Что пишут в блогах

- 1 тест = 1 проверка. Чем хорош принцип атомарности в автотестах в Postman

- Новый функционал? Подождем до последнего. Как банки к АУСН подключались

- Хочешь ещё быстрее?

- Мы незаметно перескочили странную границу

- Книга «SQL. Курс молодого бойца» уже в продаже!

- Перестать лайкать лайки

- Питер Сенге. Пятая дисциплина. Искусство и практика обучающейся организации

- Итоги 2025 года (родилась дочка, конференции, курс по ChatGPT)

- ChatGPT, подсчитай количество страниц в книге и авторских листов

- Вайб-кодинг и вайб-тестинг — полный гайд на реальных проектах в Cursor и ChatGPT

Что пишут в блогах (EN)

- AI and Testing: Improving Retrieval Quality, Part 3

- AI and Testing: Improving Retrieval Quality, Part 2

- AI and Testing: Improving Retrieval Quality, Part 1

- Requirements lead into worse testing?

- AI and Testing: Contextual Precision

- Benchmarking results - Human, Human with AI, AI with Human and where we land

- AI and Testing: Faithfulness

- So, You “10x’d” Your Work…

- AI and Testing: Answer Relevancy

- AI and Testing: Evaluation and DeepEval

Онлайн-тренинги

-

Автоматизация тестов для REST API при помощи PostmanНачало: 26 февраля 2026

-

Практикум по тест-дизайну 2.0Начало: 27 февраля 2026

-

Тестирование производительности: JMeter 5Начало: 27 февраля 2026

-

Тестирование REST APIНачало: 2 марта 2026

-

Python для начинающихНачало: 5 марта 2026

-

Азбука ITНачало: 5 марта 2026

-

Инженер по тестированию программного обеспеченияНачало: 5 марта 2026

-

Программирование на Java для тестировщиковНачало: 6 марта 2026

-

Организация автоматизированного тестированияНачало: 6 марта 2026

-

Тестирование без требований: выявление и восстановление информации о продуктеНачало: 9 марта 2026

-

Школа тест-менеджеров v. 2.0Начало: 11 марта 2026

-

Chrome DevTools: Инструменты тестировщикаНачало: 12 марта 2026

-

SQL: Инструменты тестировщикаНачало: 12 марта 2026

-

Git: инструменты тестировщикаНачало: 12 марта 2026

-

Регулярные выражения в тестированииНачало: 12 марта 2026

-

Docker: инструменты тестировщикаНачало: 12 марта 2026

-

Школа для начинающих тестировщиковНачало: 12 марта 2026

-

Bash: инструменты тестировщикаНачало: 12 марта 2026

-

Автоматизация функционального тестированияНачало: 13 марта 2026

-

Техники локализации плавающих дефектовНачало: 16 марта 2026

-

Логи как инструмент тестировщикаНачало: 16 марта 2026

-

Тестировщик ПО: интенсивный курс (ПОИНТ) со стажировкойНачало: 17 марта 2026

-

Школа Тест-АналитикаНачало: 18 марта 2026

-

Charles Proxy как инструмент тестировщикаНачало: 19 марта 2026

-

CSS и Xpath: инструменты тестировщикаНачало: 19 марта 2026

-

Применение ChatGPT в тестированииНачало: 19 марта 2026

-

Тестирование GraphQL APIНачало: 19 марта 2026

-

Создание и управление командой тестированияНачало: 19 марта 2026

-

Тестирование веб-приложений 2.0Начало: 20 марта 2026

-

Автоматизация тестирования REST API на JavaНачало: 25 марта 2026

-

Тестирование безопасностиНачало: 25 марта 2026

-

Тестирование мобильных приложений 2.0Начало: 25 марта 2026

-

Автоматизация тестирования REST API на PythonНачало: 25 марта 2026

-

Программирование на C# для тестировщиковНачало: 27 марта 2026

-

Selenium IDE 3: стартовый уровеньНачало: 3 апреля 2026

-

Программирование на Python для тестировщиковНачало: 3 апреля 2026

-

Аудит и оптимизация QA-процессовНачало: 3 апреля 2026

| Рассказ о том, как мы пилотный проект аттестации тестировщиков запускали – ч. 1 |

| 19.09.2022 00:00 |

|

Автор: Алия Токарева, ICL Services Предисловия, или Размышления о том, как много тестировщиков в IT Спойлер: очень много. Все они проходят курсы, чтобы войти в мир тестирования, но и проверка знаний новых специалистов заканчивается на моменте сдачи экзаменов на курсах и далее при собеседовании. А что дальше? Вспомнит ли тестировщик тот материал, который проштудировал во время обучения через 1 год? А через 3 года? Если в компании не применяются мероприятия по аттестации сотрудника и/или сотрудник не применяет полученные знания в работе, то память тестировщика может очень сильно подвести. И более того, это может сказаться также и на качестве тестирования («и далее, как снежный ком…»). При этом проблема может возникнуть не только в отрицательную сторону, где тестер забыл весь пройденный курс обучения, но и в положительную – специалист повысил свои навыки и знания в тестировании, а руководители недооценили своего подчиненного (И как долго недооцененный сотрудник продержится в компании? А ведь это давит морально на эмплоера). Поэтому такую проблему нужно решать. В пилотном проекте, который я организовала совместно с

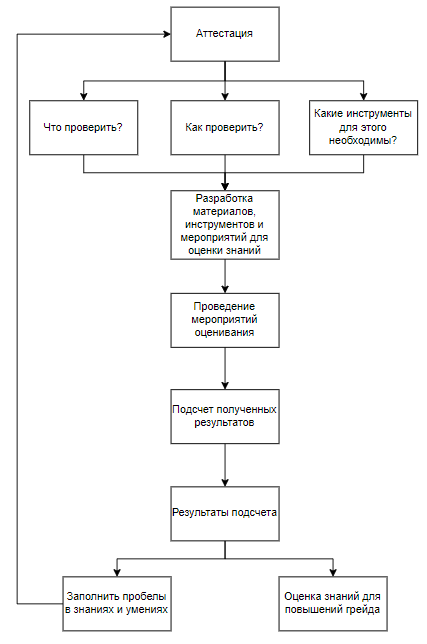

Начало работ Первым шагом работы на проекте аттестации стало составление плана:

Всё это необходимо, чтобы удостовериться в не только в хард- , но и софт-скиллах. Исходя из этого, в качестве следующего шага наметили оценку текущих знаний тестера. Определение набора знаний тестировщика 1 категорииУчитывая, что в нашей компании инженеры делятся на категории, нам следовало определить необходимый набор знаний и навыков тестировщика в начале карьеры. Конечно, невозможно требовать от тестировщика, работающего в этой области до 1 года, большой спектр скиллов. А значит, требования нужно упростить. Минимальный набор скиллов тестировщика 1-го уровня:

a.Трассировку требований; b. Самостоятельное написание тестов на основе требований и опыта; c. Составление тестов с применением техник тест-дизайна; d. Проведение ручного API-тестирования; e. Написание простых SQL-запросов; f. Коммуникативные навыки для получения консультации в различных вопросах, связанные с тестируемым ПО. Вывод: нужно составить план, по областям которых и будет проходиться оценка среза знаний

План оценивания по текущему грейду Предметные области для оценивания:

a. Бизнес-разработка;

a. Выполнение и понимание готовых тестов; b. Специализация (по видам тестирования);

Следовательно, по данным областям и следует составить список проверок. В нашем случае это было:

Схема устного тестирования знанийРанее в моих планах было составить тест с несколькими вариантами ответа, но такая задумка не прошла успешно проверку руководителем, потому что оцениваемые тестировщики с легкостью сообщат ответы и другим тестерам, кроме того, верный вариант "гуглится" в интернете. Поэтому было решено задавать вопросы устно, а ответы уже оценивать по вероятности попадания в правильный ответ. Далее подсчет баллов происходит следующим образом. Например, у нас имеется общее количество вопросов 20 с 4-мя ответами по степени градации, где высший балл за самый точный и полный ответ одного вопроса равняется 5 (100/20 = 5). Далее, эти 5 баллов делим на 4, чтобы определить разницу, на которую нужно уменьшать высший балл (5/4 = 1,25), затем минусуем (5 – 1,25 = 3,75), потом еще минусуем (3,75 – 1,25 = 2,5), и еще раз минусуем (2,5 = 1,25 = 1,25), где в результате выходит: 5 – самый высший балл за полный и верный ответ; 3,75 – балл ниже, потому что в ответе тестировщика были упущены ключевые определения; 2,5 – балл занижен из-за достаточно плохого ответа тестера на вопрос; 1,25 – балл за самый скудный ответ. Отсюда находится и минимальный порог, где сумма самых низких баллов равняется 25 (1,25 * 20 = 25). Или вы сами можете установить минимальный проходной порог. В результате тут можно определить вероятность попадания ответа, так как нельзя поставить 0 баллов, если ответ тестировщика в точности не совпал с верным ответом. Потому что тестер ведь что-то да ответил, пусть даже размазано, но ключевые слова в его ответе присутствуют. Опрос экспертов

Ранее эксперты писали свою оценку в специально отведенных полях на внутреннем портале компании. Причем часто оценка отображала очень скудный вид, так как экспертам необходимо написать все качества (софт-скиллы, хард-скиллы), которые он увидел в сотруднике. (а это попробуй вспомнить за весь год) Помню, как однажды на звонке один из экспертов сказал мне: «на написание оценки ушло два выходных». В такой ситуации было решено составить ряд вопросов по интересующимся областям качеств тестировщика, и далее провести опрос эксперта на звонке. Темы вопросов те же, что и в блоке «План оценивания по текущему грейду». Этот вид оценивания облегчает работу не только самому эксперту, но и руководителю, который дает заключение аттестации, потому что получает более полное описание качеств тестера. Оценивающего участника (эксперта) назначают сами тестировщики, а дальше дело за малым – это назначить встречи на не более чем 30 минут. Подсчет баллов происходит аналогично, но в некоторых моментах градация идет не «вниз», а «вверх», например, у нас есть 20 вопросов, 5 баллов – это минимальный балл, в вопросе есть 3 варианта ответа, соответственно: 5 / 3 = 1,67, где 5 + 1,67 = 6,67, далее 6,67+1,67 = 8,34 – таким образом получается, что 8,34 балла – это высший балл. К такой градации можно отнести вопрос «Каким образом тестировщик проводит тестирование?». Например, какой способ применяется при тестировании программного приложения: «Черный ящик», «Серый ящик» или «Белый ящик»? Стандартное, что можно потребовать от тестировщика 1 уровня – это «Черный ящик», а вот «Серый ящик» – это уже повышение скиллов, и 3,33 балла никак нельзя поставить в оценку, если 5 – высший балл (5 – 1,67 = 3,33). Оценка присланного материалаМатериал, который запрашивался у оцениваемых тестировщиков – тест-кейсы, баг-репорты, PDP, отчеты о проделанной работе и о выполненных целях в PDP за квартал и, по желанию, чек-листы и другие тесты с использованием техник тест-дизайна. В этой части пилотного проекта аттестации не все прошло гладко – тестировщики не прислали отчеты о проделанной работе и о выполненных целях PDP, а некоторые и вовсе не прислали PDP. Поэтому было решено опираться на оценку тест-кейсов и баг-репортов. Критерии, которым должны соответствовать объекты тест-кейсов и баг-репортов:

Подсчет таких материалов проводится следующим образом: 100 делится на количество составляющих в критериях (например, если заголовок имеет 5 составляющих, шаги аналогично 5 критериев, то 100/10). Не стоит забывать, что оцениваемый тестировщик 1-го уровня не всегда пишет 100% идеальный тест-кейс или баг-репорт, поэтому в этом случае балл занижается:

ЗаголовокТак была проведена первая часть пилотного проекта аттестации тестировщика по текущим знаниям. И скажу, что самим тестировщикам понравилась аттестация. Хоть для них это и был стресс, сотрудники увидели, в каких моментах имеют пробелы в знаниях, а где-то получили идею для улучшения качества тестирования на своем проекте. И еще больше скажу: не только тестеры, но и аналитики увидели другой подход рабочего процесса, который повышает качество уже самого программного продукта. Не спорю, что в этом проекте аттестации можно найти кучу замечаний, но на то и программа является пилотной, которая в дальнейшем будет оптимизироваться. Спасибо, что прочитали первую часть статьи, вторая часть будет посвящена знаниям инженера для повышения грейда. |