Что пишут в блогах

- Книга «SQL. Курс молодого бойца» уже в продаже!

- Перестать лайкать лайки

- Питер Сенге. Пятая дисциплина. Искусство и практика обучающейся организации

- Итоги 2025 года (родилась дочка, конференции, курс по ChatGPT)

- ChatGPT, подсчитай количество страниц в книге и авторских листов

- Вайб-кодинг и вайб-тестинг — полный гайд на реальных проектах в Cursor и ChatGPT

- Новогодний QA квиз

- Не просри свое время

- Гуру на Урале 4 декабря

- Мои 12 недель в году. Часть 32 (ДР Влада и мой, болезни...)

Что пишут в блогах (EN)

- The people who lift you - Why mentors matter more than we admit

- The Coming Productless Revolution

- Bucket of trouble, if you don't keep an eye on AI

- Professional Versus Hobby Code in the AI Age: What’s the Difference?

- 2025 in review

- Things which were not on my 2025 bingo card

- 2025 - The Year in Review

- 2026 – Changing Gears

- How should we test this? Part 6 - Reporting

- Looking Back at 2025

Онлайн-тренинги

-

Тестирование REST APIНачало: 2 февраля 2026

-

Тестировщик ПО: интенсивный курс (ПОИНТ) со стажировкойНачало: 3 февраля 2026

-

Школа тест-менеджеров v. 2.0Начало: 4 февраля 2026

-

Python для начинающихНачало: 5 февраля 2026

-

Автоматизация тестов для REST API при помощи PostmanНачало: 5 февраля 2026

-

Азбука ITНачало: 5 февраля 2026

-

Инженер по тестированию программного обеспеченияНачало: 5 февраля 2026

-

Применение ChatGPT в тестированииНачало: 5 февраля 2026

-

Аудит и оптимизация QA-процессовНачало: 6 февраля 2026

-

Тестирование веб-приложений 2.0Начало: 6 февраля 2026

-

Школа Тест-АналитикаНачало: 11 февраля 2026

-

Chrome DevTools: Инструменты тестировщикаНачало: 12 февраля 2026

-

SQL: Инструменты тестировщикаНачало: 12 февраля 2026

-

Git: инструменты тестировщикаНачало: 12 февраля 2026

-

Регулярные выражения в тестированииНачало: 12 февраля 2026

-

Docker: инструменты тестировщикаНачало: 12 февраля 2026

-

Школа для начинающих тестировщиковНачало: 12 февраля 2026

-

Bash: инструменты тестировщикаНачало: 12 февраля 2026

-

Программирование на C# для тестировщиковНачало: 13 февраля 2026

-

Техники локализации плавающих дефектовНачало: 16 февраля 2026

-

Логи как инструмент тестировщикаНачало: 16 февраля 2026

-

Charles Proxy как инструмент тестировщикаНачало: 19 февраля 2026

-

CSS и Xpath: инструменты тестировщикаНачало: 19 февраля 2026

-

Тестирование GraphQL APIНачало: 19 февраля 2026

-

Selenium IDE 3: стартовый уровеньНачало: 20 февраля 2026

-

Программирование на Python для тестировщиковНачало: 20 февраля 2026

-

Автоматизация тестирования REST API на PythonНачало: 25 февраля 2026

-

Тестирование безопасностиНачало: 25 февраля 2026

-

Автоматизация тестирования REST API на JavaНачало: 25 февраля 2026

-

Тестирование мобильных приложений 2.0Начало: 25 февраля 2026

-

Тестирование производительности: JMeter 5Начало: 27 февраля 2026

-

Практикум по тест-дизайну 2.0Начало: 27 февраля 2026

-

Организация автоматизированного тестированияНачало: 6 марта 2026

-

Программирование на Java для тестировщиковНачало: 6 марта 2026

-

Тестирование без требований: выявление и восстановление информации о продуктеНачало: 9 марта 2026

-

Автоматизация функционального тестированияНачало: 13 марта 2026

-

Создание и управление командой тестированияНачало: 19 марта 2026

| Сравнение производительности инструментов нагрузочного тестирования |

| 17.03.2022 00:00 | ||||||||||||||||||

|

Автор: Сергей Лысов Всем привет, меня зовут Сергей, я занимаюсь тестированием производительности. Недавно поднялся вопрос в выборе инструмента для воспроизведения довольно интенсивной нагрузки, в основном по HTTP. Инструментов для тестирования производительности сейчас представлено довольно много, в том числе многие из них являются Open Source — проектами и доступны бесплатно. Стало интересно, какой же инструмент справится с подобной задачей лучше, сможет воспроизвести большую нагрузку затратив меньше ресурсов. Решил поставить несколько популярных инструментов в одинаковые условия и проверить результат. Если интересно что из этого получилось, добро пожаловать под кат. Данное тестирование не претендует на объективность, и показывает результаты только в одних конкретных условиях с конкретным подходом и только при использовании HTTP. Возможно что при изменении подхода или в результате какого-либо тюнинга результаты будут совершенно другие. Итак, рассмотрим претендентовGatling (https://gatling.io/)

Open Source инструмент для тестирования производительности, написан на Scala, поэтому работает на JVM и требует установленную Java, для разработки скриптов можно использовать Scala, Java или Kotlin, но основным языком все-таки считается Scala, большинство встречающихся примеров написано именно на нем. Из коробки умеет работать с HTTP и WebSocket, но для популярных протоколов существуют не официальные плагины. Не имеет интерфейса, все скрипты пишутся при помощи кода или рекордера. Умеет строить довольно красивые краткие отчеты. Gatling не очень популярен в России, но его популярность стремительно растет в последнее время.

Apache JMeter (https://jmeter.apache.org/)

Наверно самый известный инструмент для нагрузочного тестирования. Написан на Java, для работы требуется JVM, поэтому может выполняться в любой среде где есть Java. Имеет довольно понятный интерфейс. Большую часть логики запросов можно сделать без программирования, добавляя и конфигурируя нужные блоки. Из коробки поддерживает довольно много протоколов. А так же для JMeter существует огромное количество плагинов реализующих более специфические протоколы которых нет по-умолчанию. Так же вокруг JMeter очень большое сообщество специалистов, в том числе русскоязычных. K6 (https://k6.io/)

Подающий надежды новичок в области тестирования производительности. Распространяется бесплатно, имеет коммерческую версию, предоставляемую как сервис. Разработан на Go, скрипты пишутся на JS, из коробки умеет работать только с HTTP, но уже имеется набор плагинов для популярных протоколов. Не имеет интерфейса, все делается при помощи кода и параметров запуска. Locust (https://locust.io/)

Open source фреймворк для тестирования производительности разработанный на Python, скрипты так же пишутся на Python. Очень прост в освоении, особенно для знакомых с Python. Имеет веб-интерфейс для запуска, конфигурирования параметров теста и просмотра результатов. MF LoadRunner (https://www.microfocus.com/)

Единственный проприетарный инструмент в нашем тесте. Очень популярный в банковской сфере, поддерживает огромное количество протоколов, имеет удобные приложения с интерфейсами для разработки, запуска тестов и анализа результатов тестирования. В зависимости от протокола доступны разные языки написания скриптов. Для тестирования был написан примитивный веб-сервер на языке Go, который обрабатывает единственный GET-запрос и возвращает статический ответ. Кому интересно, код ниже.

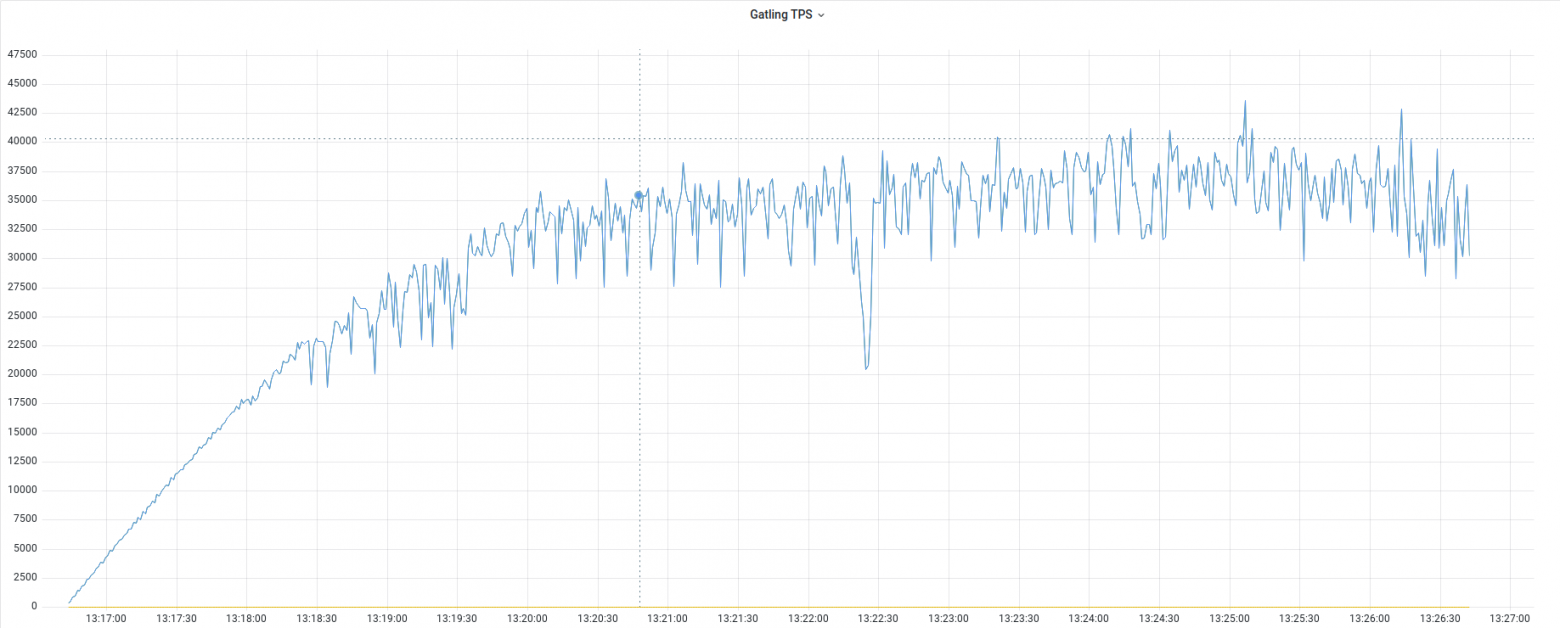

Максимальная производительность сервиса достигнутая на хост-машине находится примерно на уровне 150 000 запросов в секунду. Все инструменты, кроме LoadRunner, запускались на виртуальной машине QEMU с ОС Ubuntu Server 20.04, версия ядра 5.4.0-92-generic, конфигурация виртуальной машины 4vCPU, 4GB RAM, само тестируемое приложение размещено на хост-машине, где и развернута виртуалка. Конфигурация хост-машины: AMD Ryzen 5 5500U, 16GB RAM. Kubuntu 21.10 версия ядра 5.13.0-27-generic. Для увеличения количества подключений, на обоих линуксах были выполнены следующие настройки: Увеличено максимальное число открытых файлов в /etc/security/limits.conf и количество подключений LoadRunner запускался на аналогичной конфигурации, но в качестве ОС уже была Windows Server 2019. Мониторинг построен на связке Telegraf, Influx, Grafana. Telegraf установлен на обоих машинах, Influx и Grafana установлены на хост-машине. Все инструменты, кроме LoadRunner, были настроены на отправку данных в Influx, понимаю что это создает лишнюю нагрузку, но зачем нужно тестирование без мониторинга. Результаты тестированияЕсли подробности не интересны, лучше сразу перейти к таблице в конце статьи. GatlingДля тестирования использовалась версия 3.7.3 (последняя на момент написания статьи) Скрипт довольно примитивный, каждый виртуальный пользователь делает запрос, каждые 2 мс., количество пользователей возрастает от 1 до 300 за 10 минут.

Стабильный рост нагрузки происходил примерно до 22 500 запросов в секунду, что можно считать максимальной производительностью для Gatling в данных условиях. Важно заметить что, чем больше виртуальных пользователей, тем больше создается сетевых коннектов, которые потребляют большую часть ресурсов, при быстром выполнении запросов и минимальном количестве пользователей создается максимальная производительность.

Как можно заметить, рост количества запросов продолжался и дальше, и можно заметить пики на уровне 40 000 запросов в секунду, однако производительность на этом уровне была уже очень нестабильной, поэтому за максимум считаю 22 500 запросов в секунду.

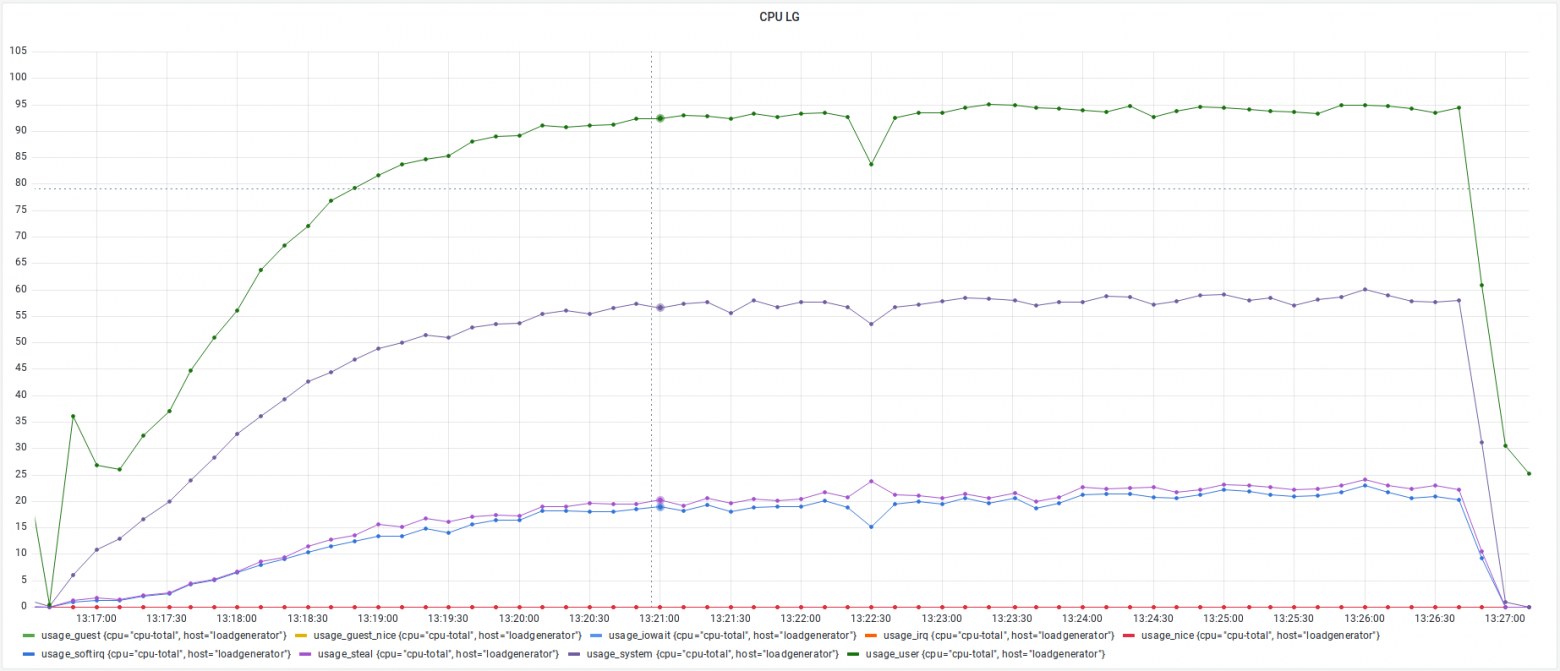

Перед началом нестабильной работы утилизация процессора виртуалки находилась на уровне около 65%, думаю такие показания связаны со склонностью виртуалок занижать потребление процессора при измерении изнутри.

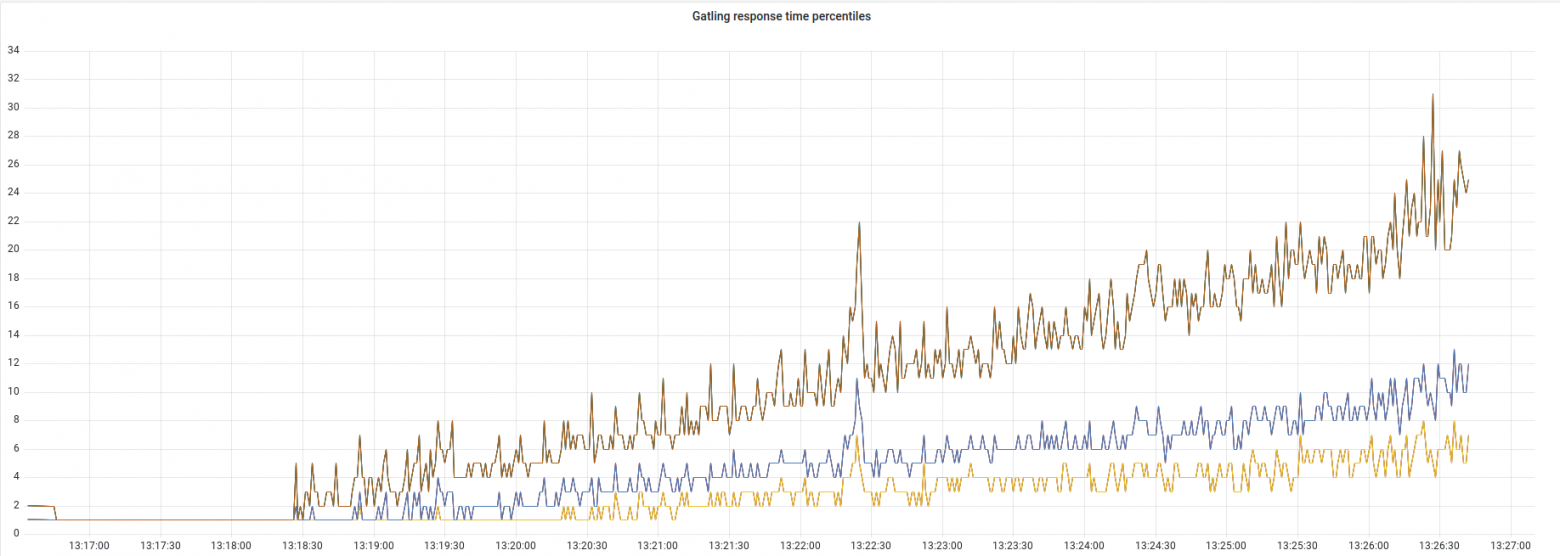

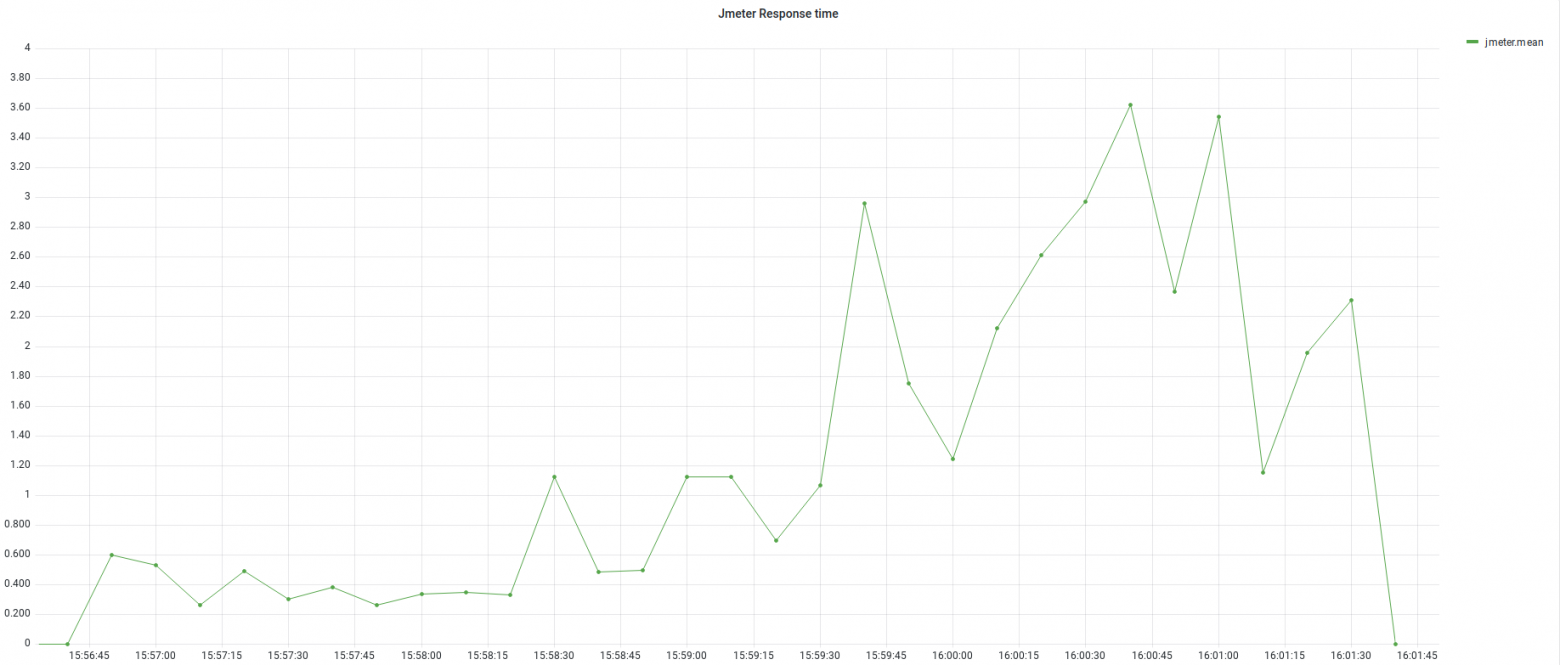

Время отклика начало расти, как только уровень нагрузки стал нестабильным.

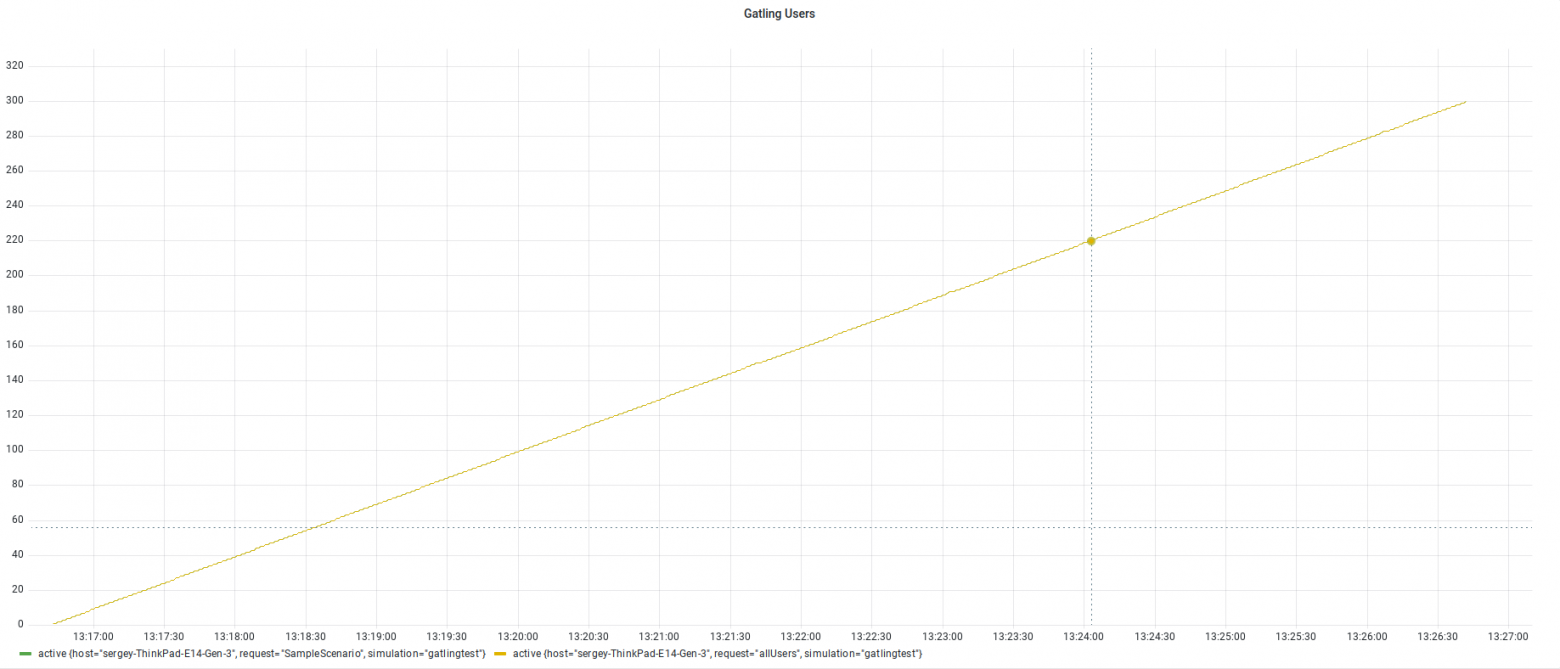

Количество виртуальных пользователей увеличивалось равномерно

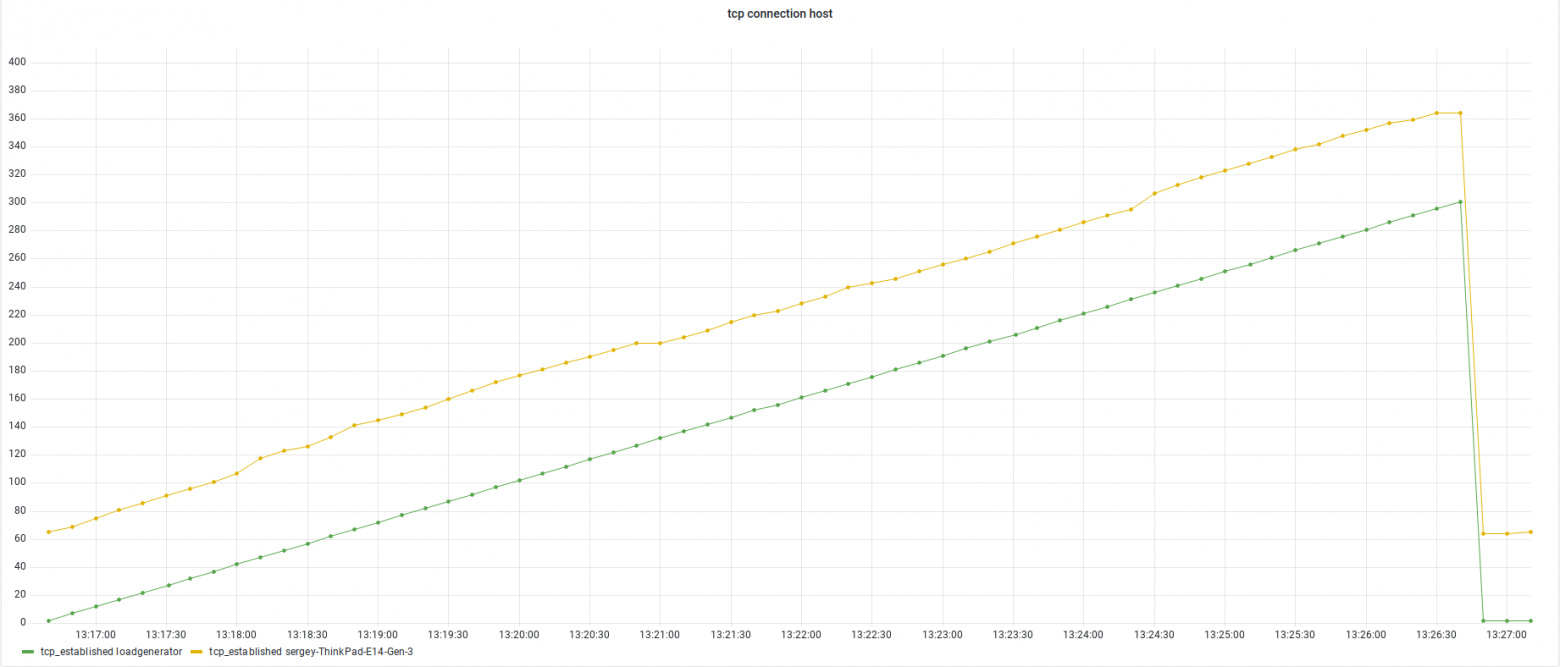

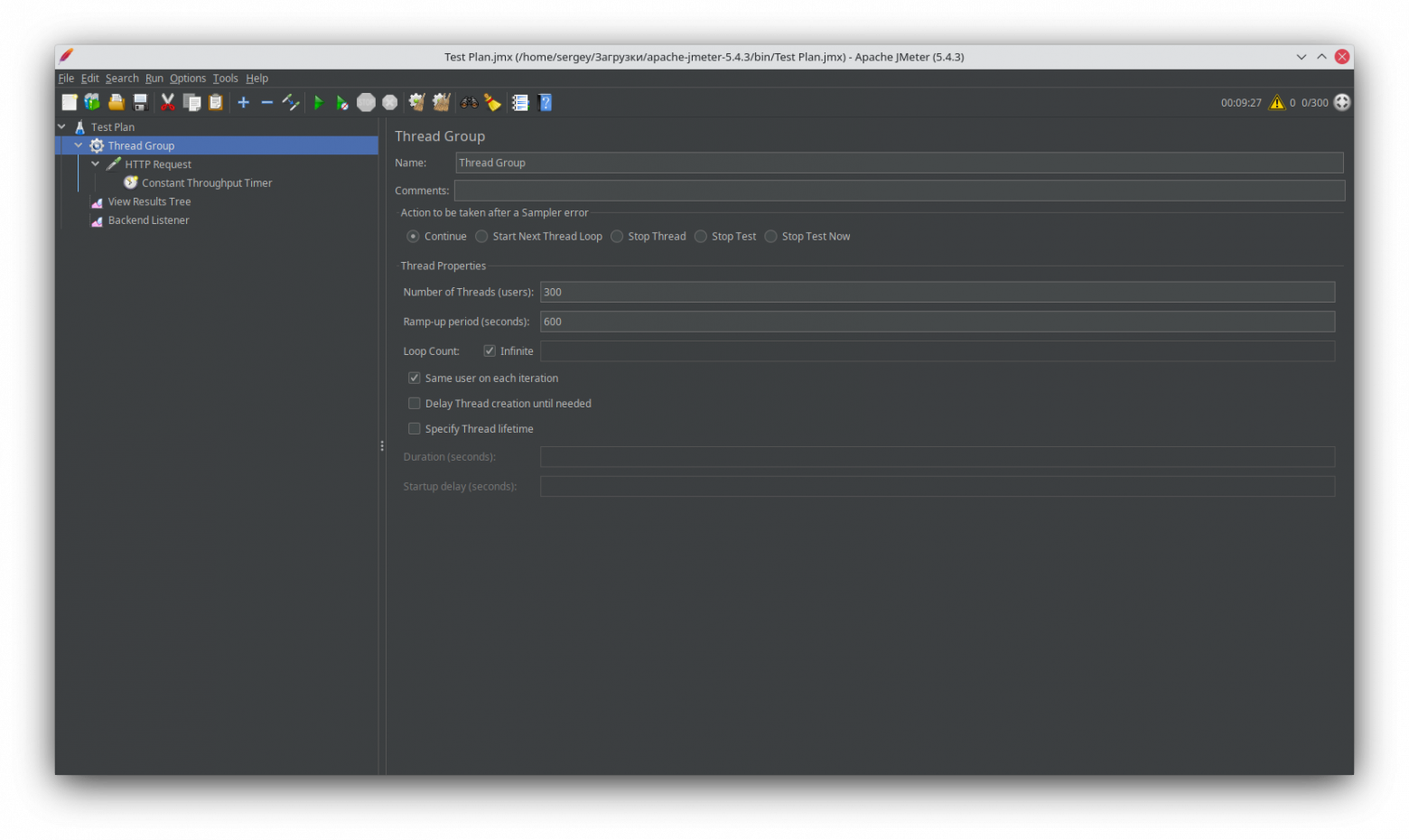

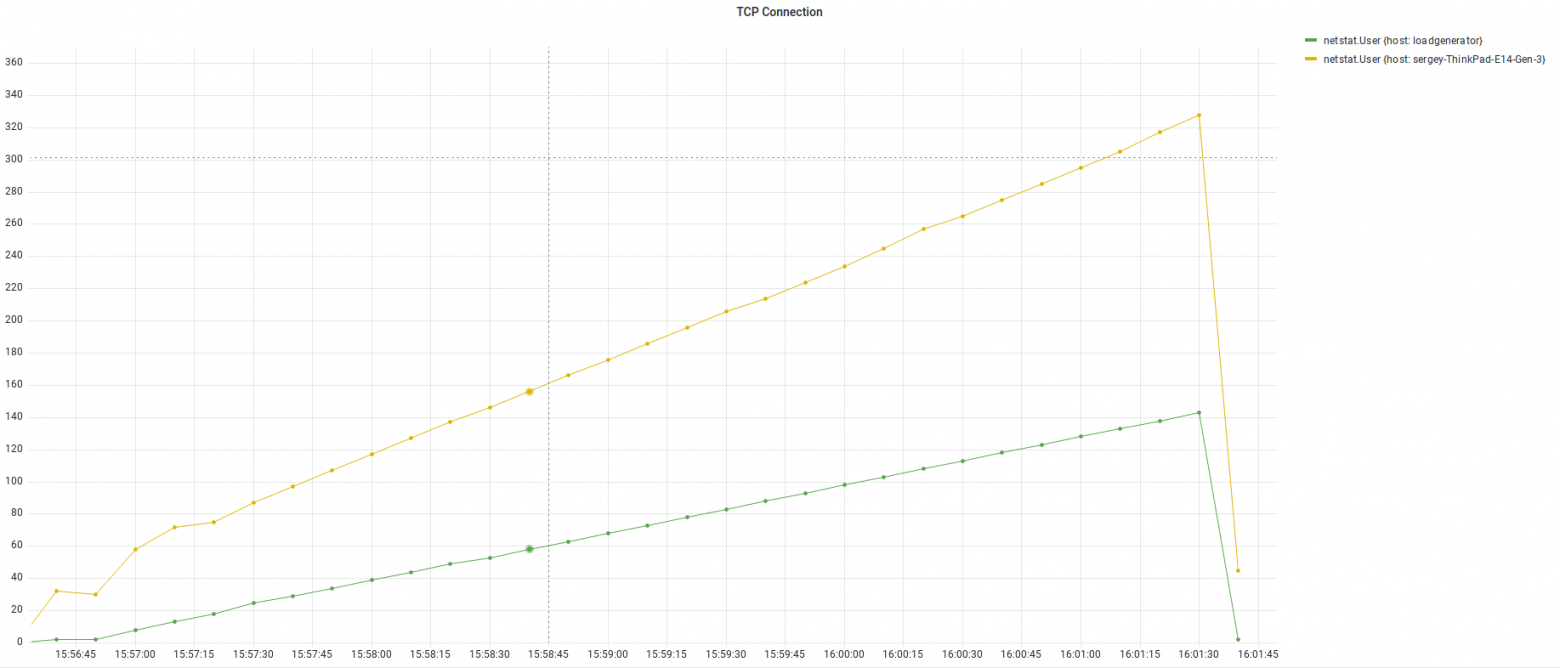

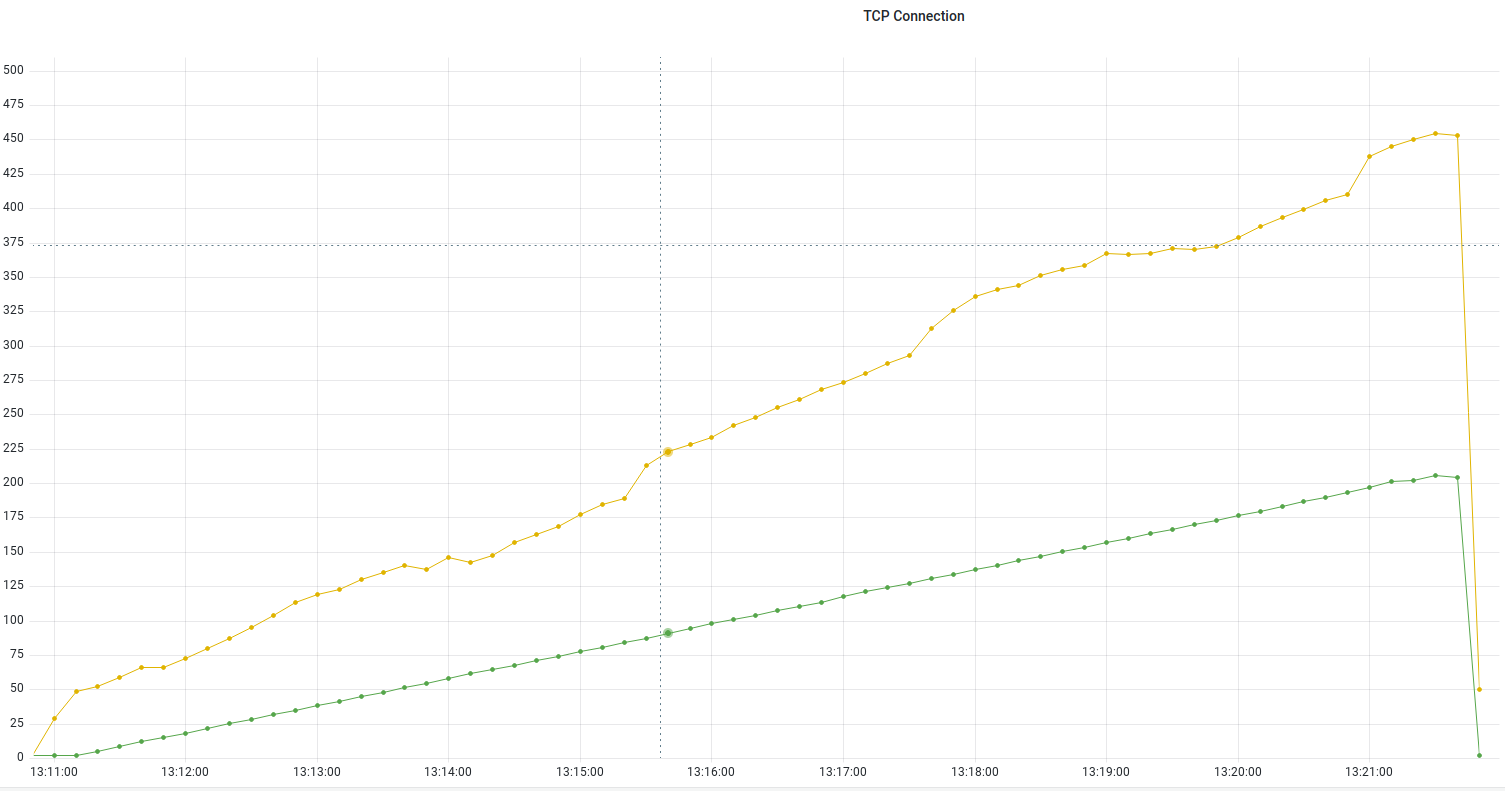

Количество соединений росло пропорционально нагрузке JMeterДля тестирования использовалась версия 5.4.3 (последняя на момент написания статьи) Подход к формированию скрипта здесь аналогичный, для пауз использовался Constant Throughput Timer с целевой производительностью 30 000 запросов в минуту на один поток. Количество пользователей 300, запускаются за 10 минут.

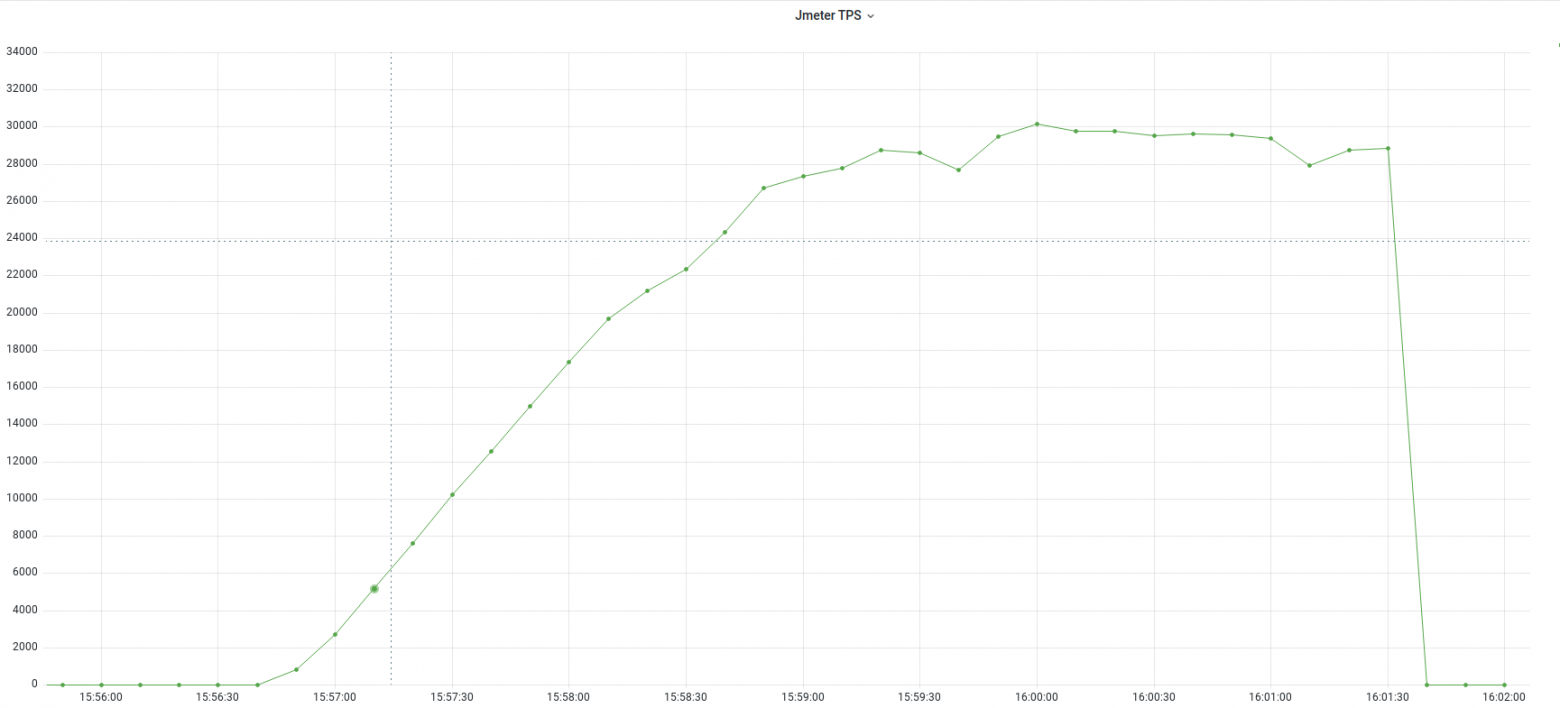

Стабильный рост нагрузки продолжался примерно до 28 000 запросов в секунду, Jmeter создает минимальное количество подключений, что положительно сказывается на производительности.

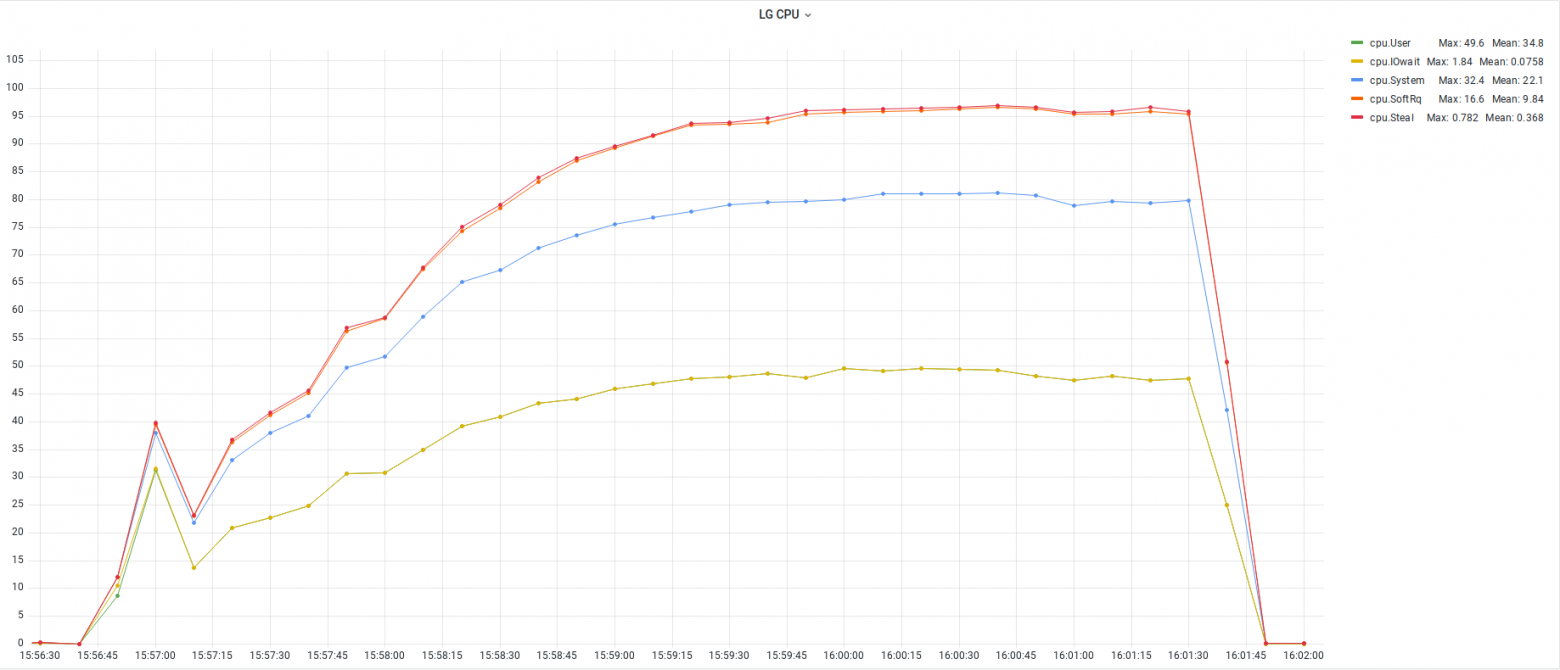

Количество запросов возрастало довольно стабильно, пока не закончились ресурсы CPU.

По достижению максимальной утилизации процессора, перестала расти и производительность.

Оперативная память утилизировалась довольно умеренно.

Количество подключений возрастало пропорционально нагрузке.

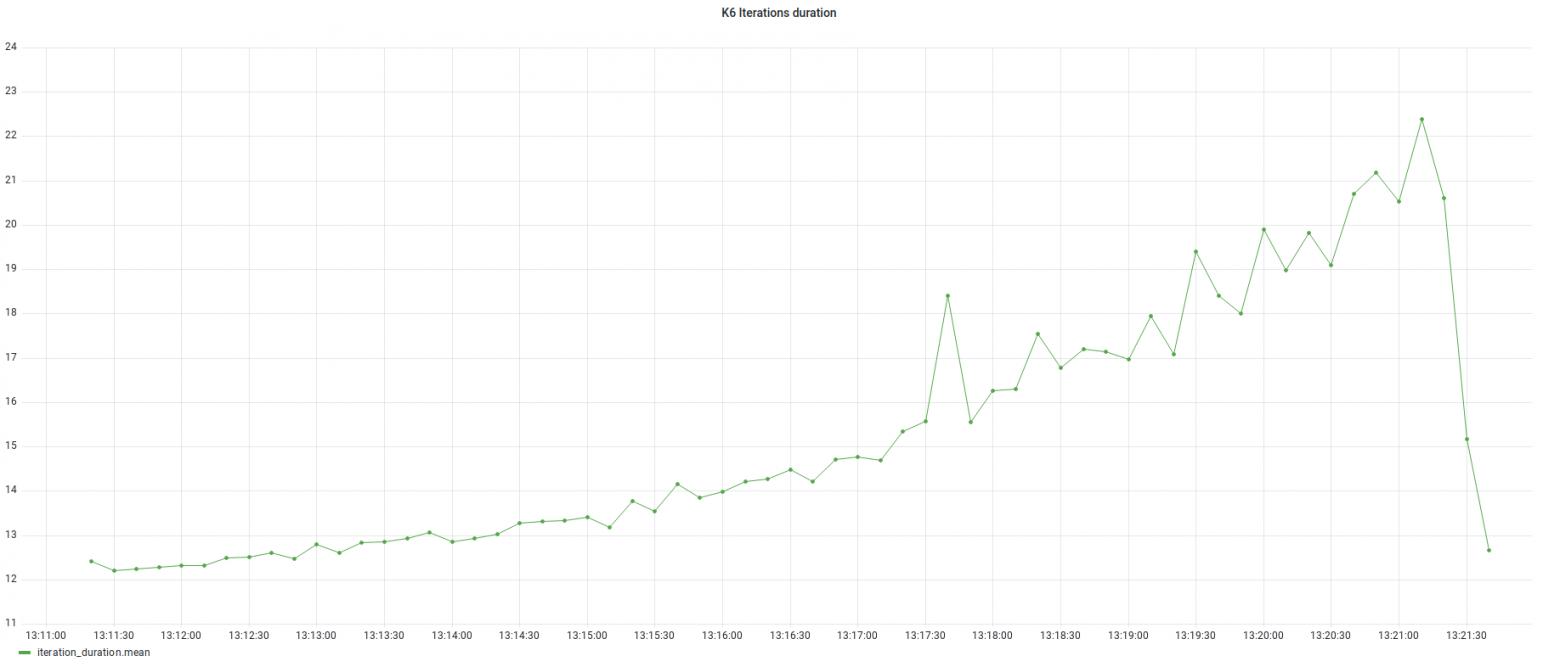

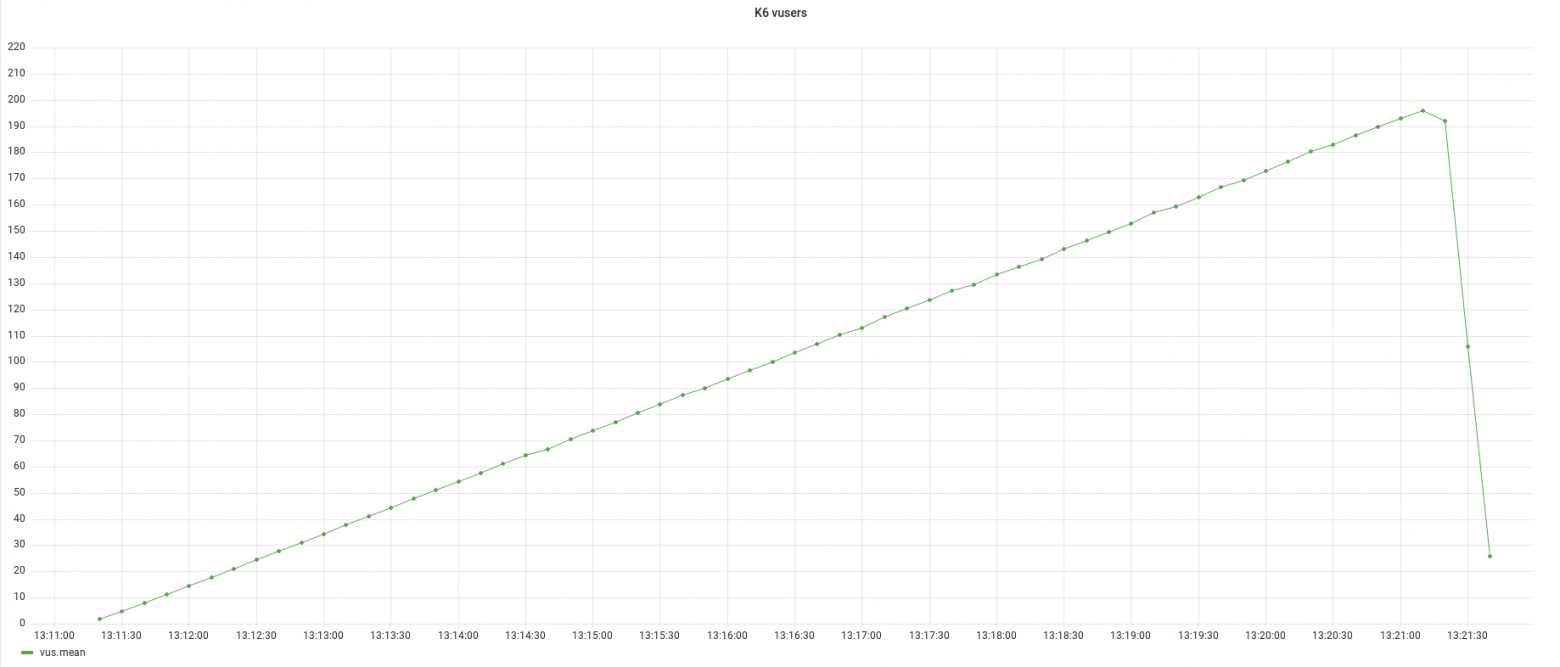

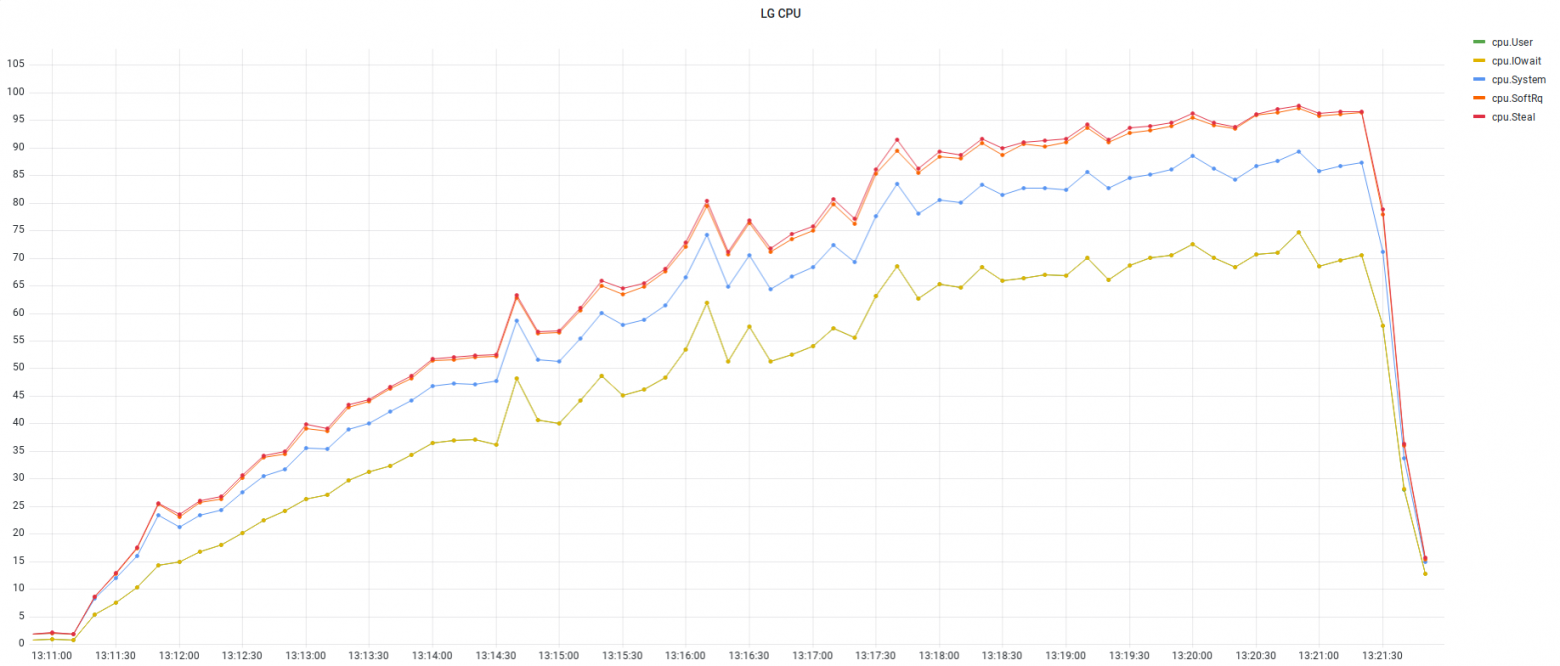

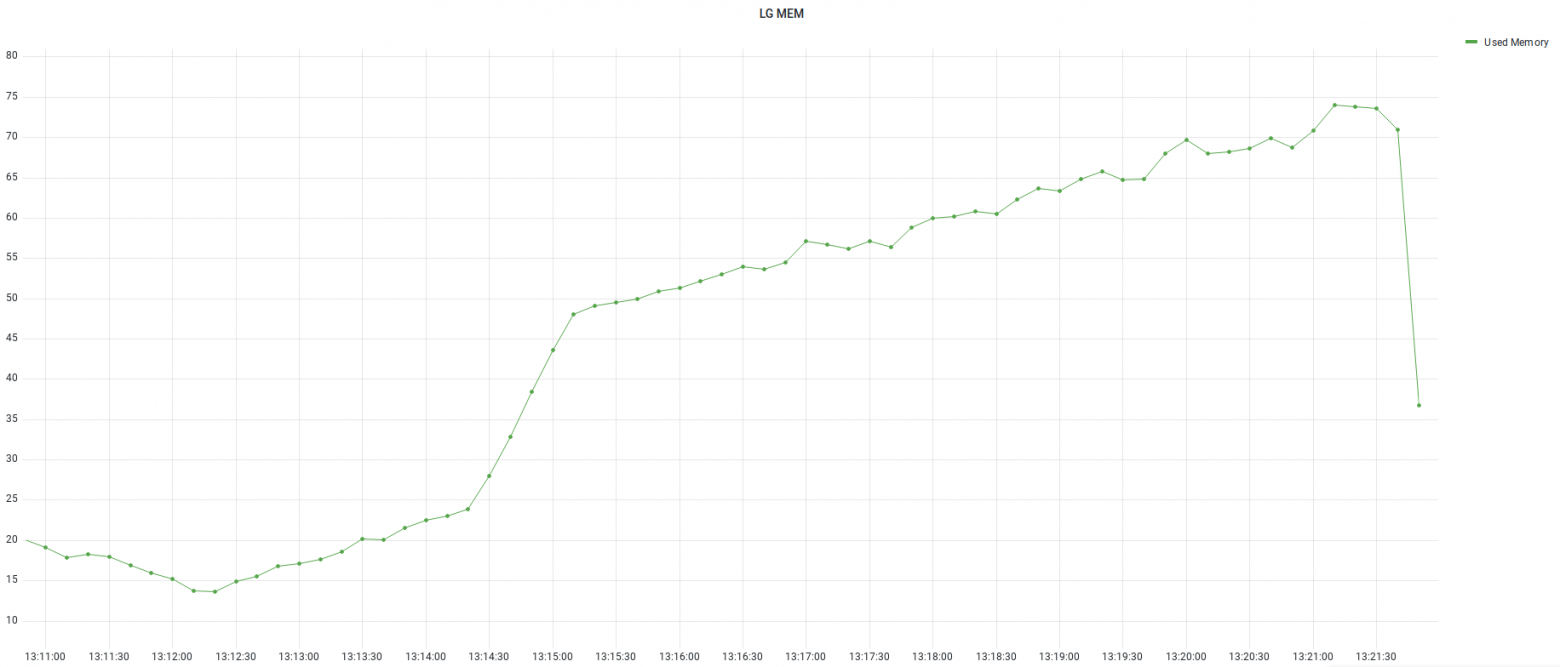

Время отклика начало расти, как только достигли максимальной производительности. K6Для тестирования использовалась версия k6 v0.36.0. Использовался примерно такой же подход к формированию скрипта пауза между итерациями 10 мс. Запуск 200 виртуальных пользователей за 10 минут.

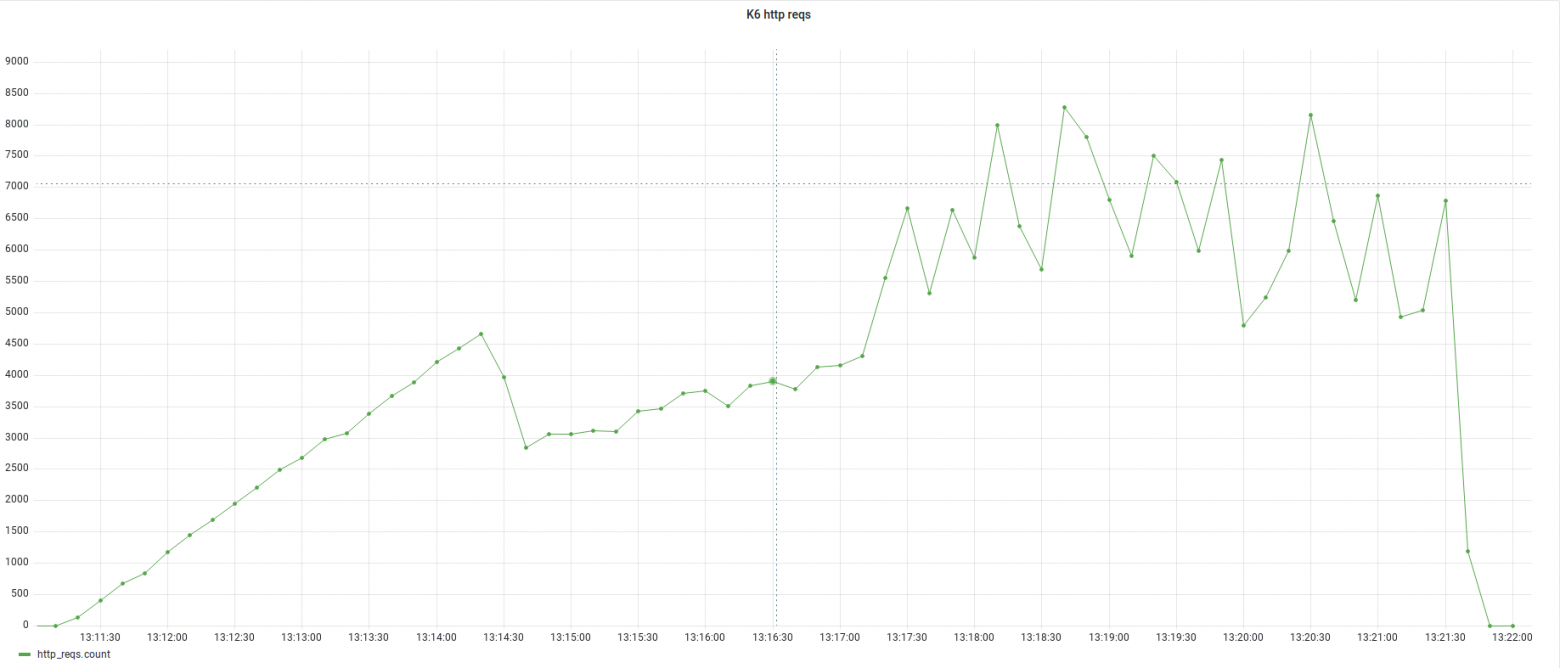

Стабильный рост нагрузки продолжался примерно до 4 500 запросов в секунду.

В пике производительность возрастала до 8000 запросов в секунду, но на таком уровне нагрузка была очень нестабильной.

Время отклика возрастало на протяжении всего теста.

Количество виртуальных пользователей возрастало равномерно.

Утилизация CPU в начале нестабильной нагрузки была на уровне около 65%.

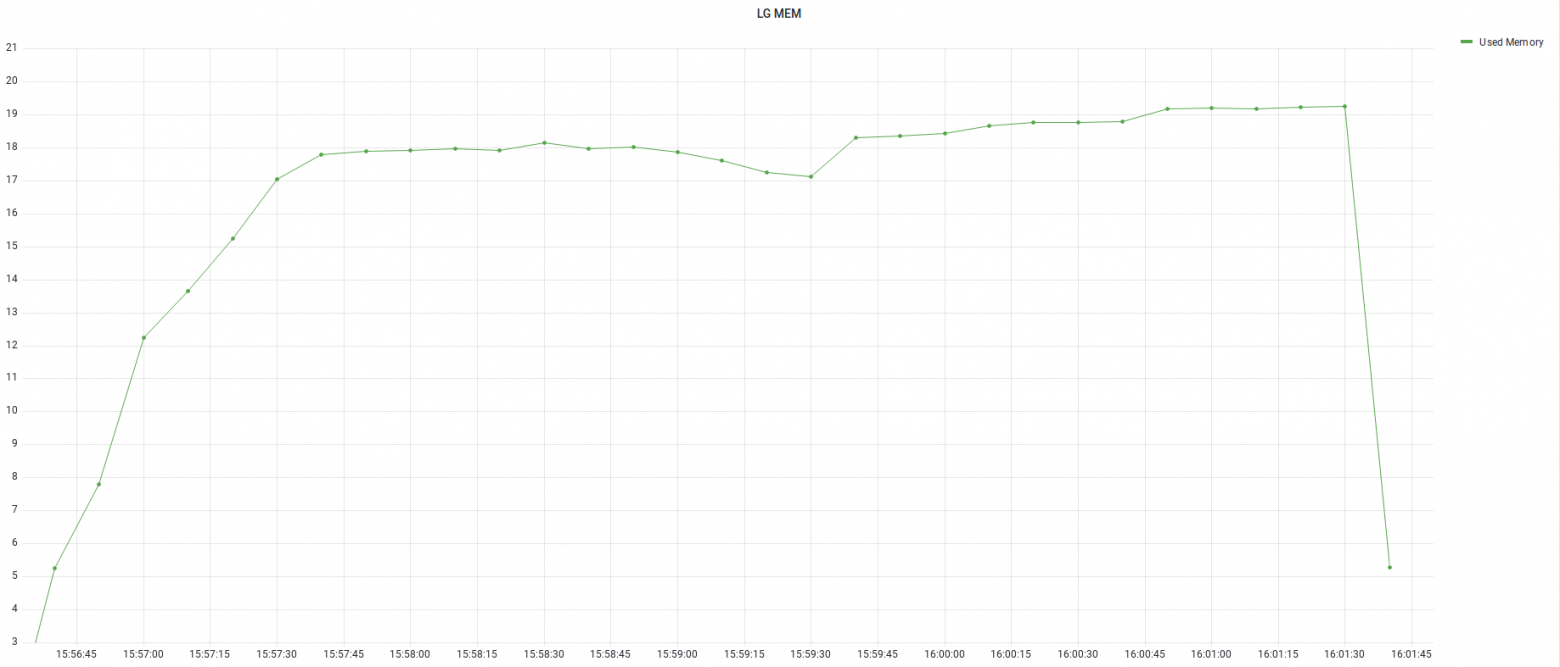

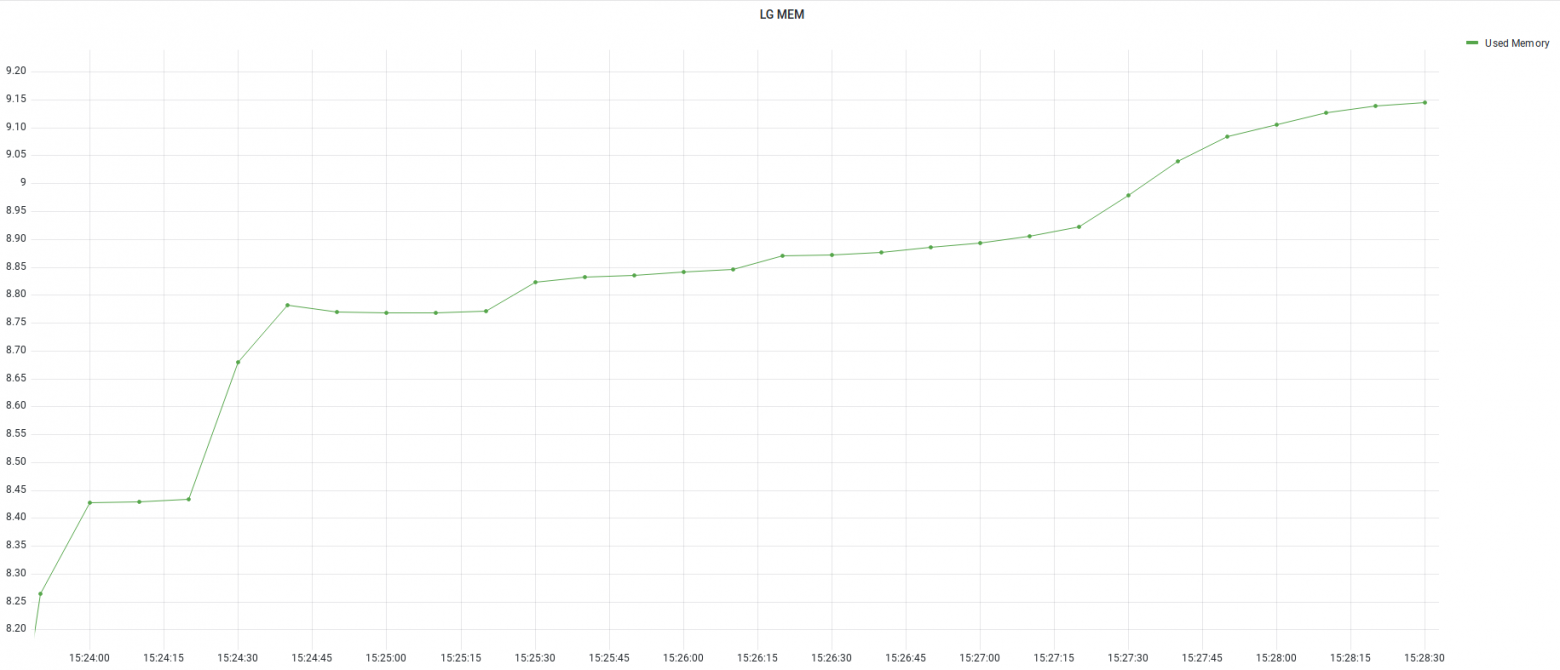

Оперативная память утилизировалась существенно, наблюдался значительный рост утилизации в начале нестабильной работы.

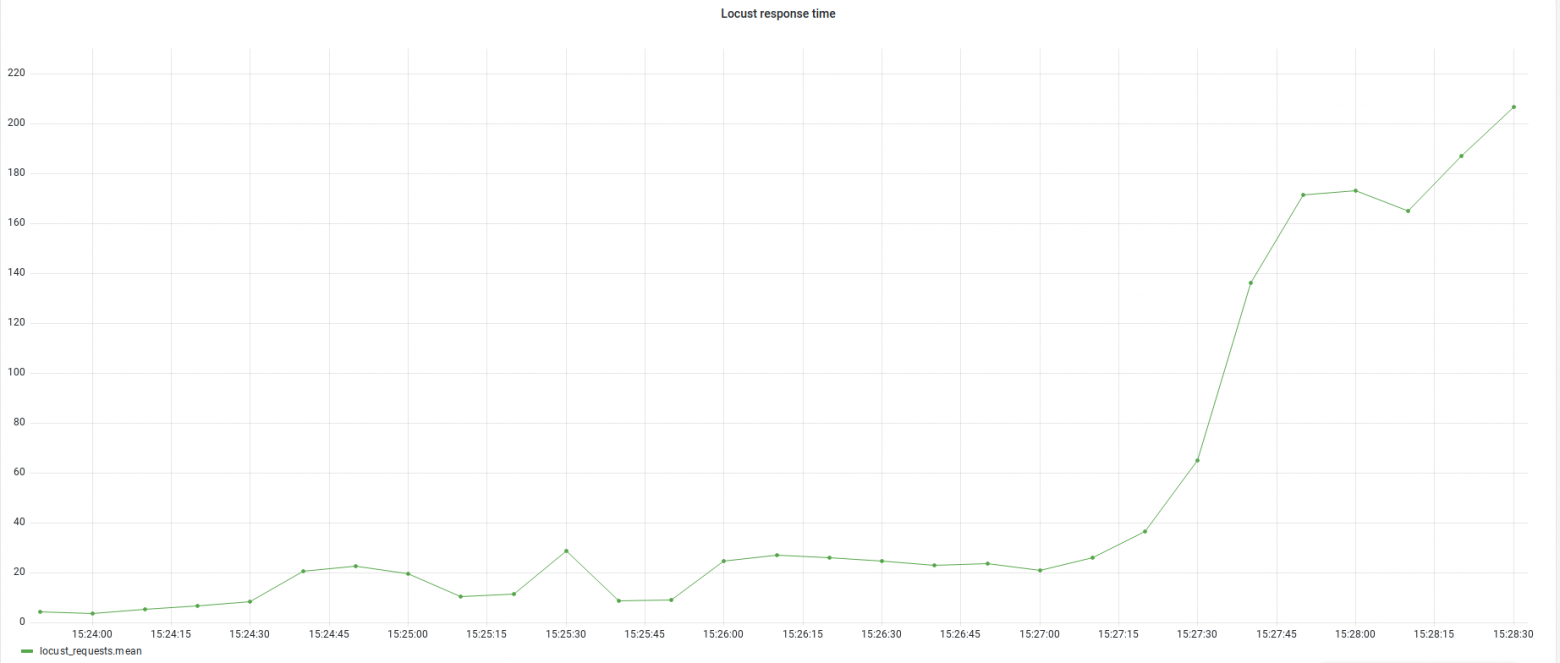

Количество коннектов росло пропорционально нагрузке LocustДля тестирования использовалась версия 2.5.1. В скрипте прописаны паузы в 200 мс. Между запросами, количество пользователей 200, запускаются по 1 в секунду. Для отправки результатов в Influx использовалась библиотека InfluxDBListener.

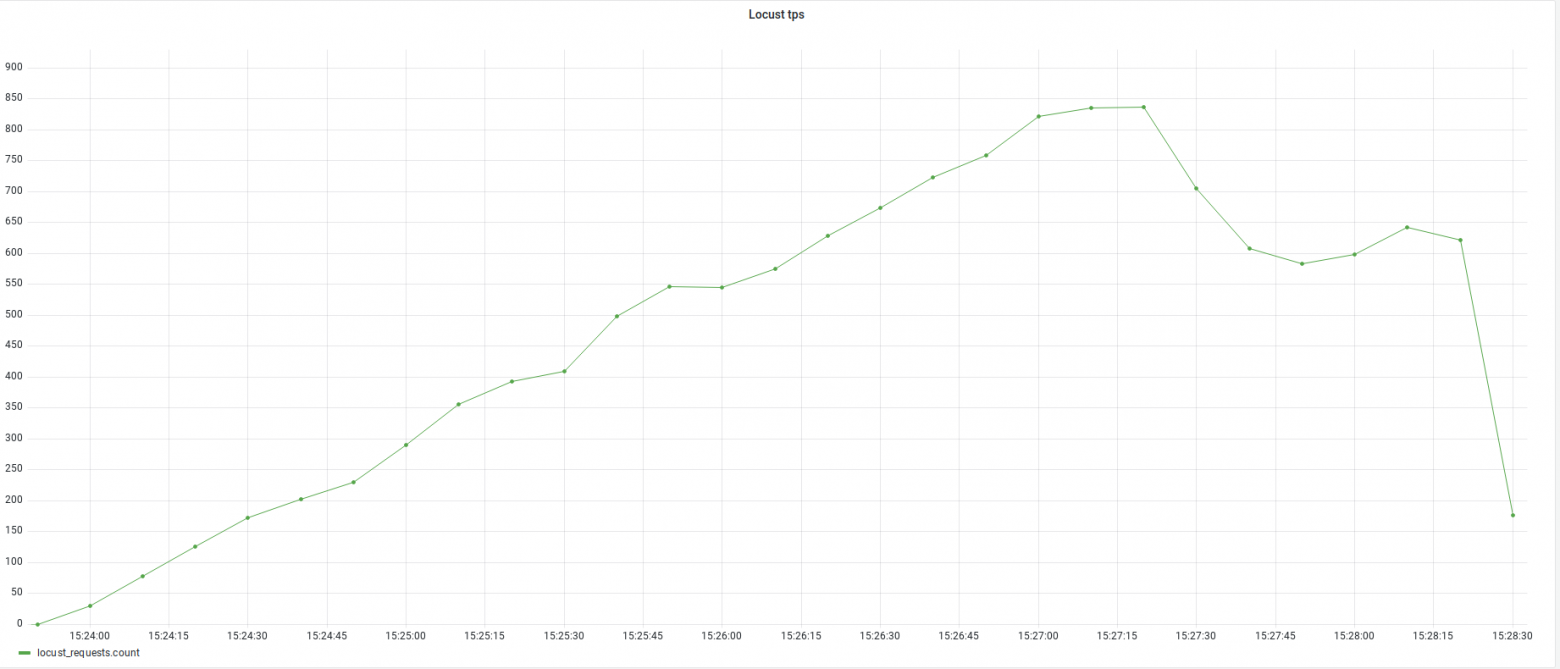

Стабильный рост производительности наблюдался до 835 запросов в секунду, после происходит существенны спад и производительность становится нестабильной.

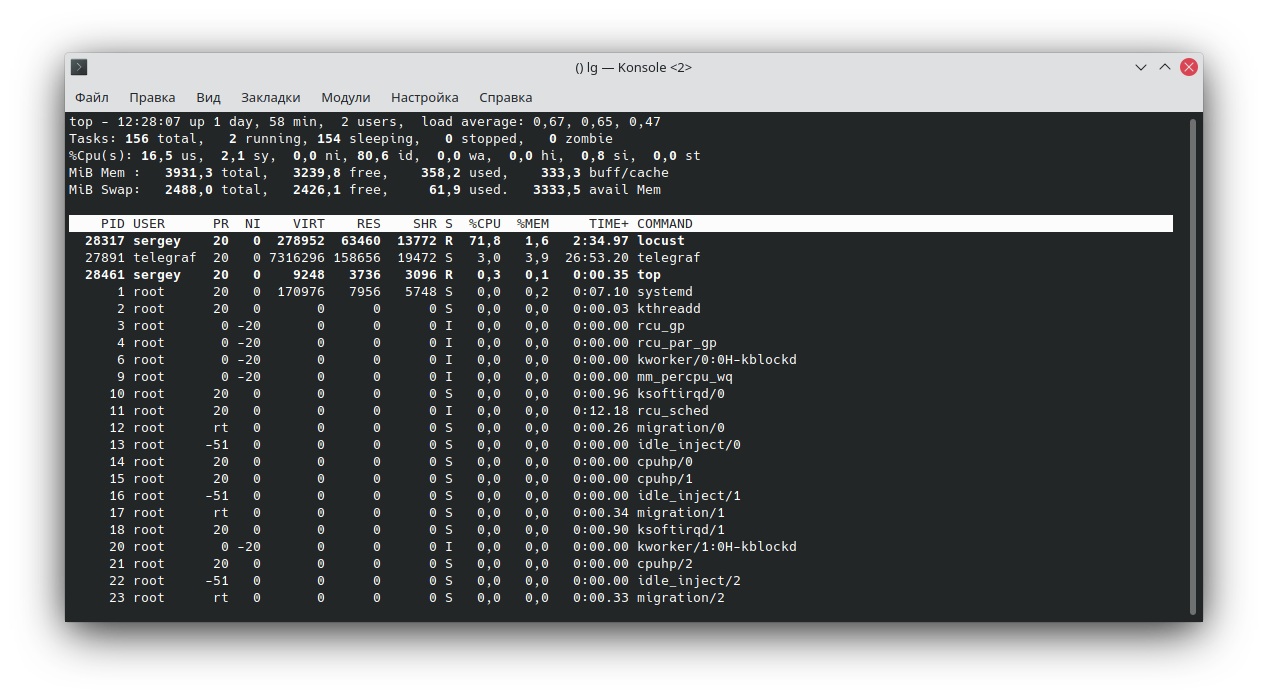

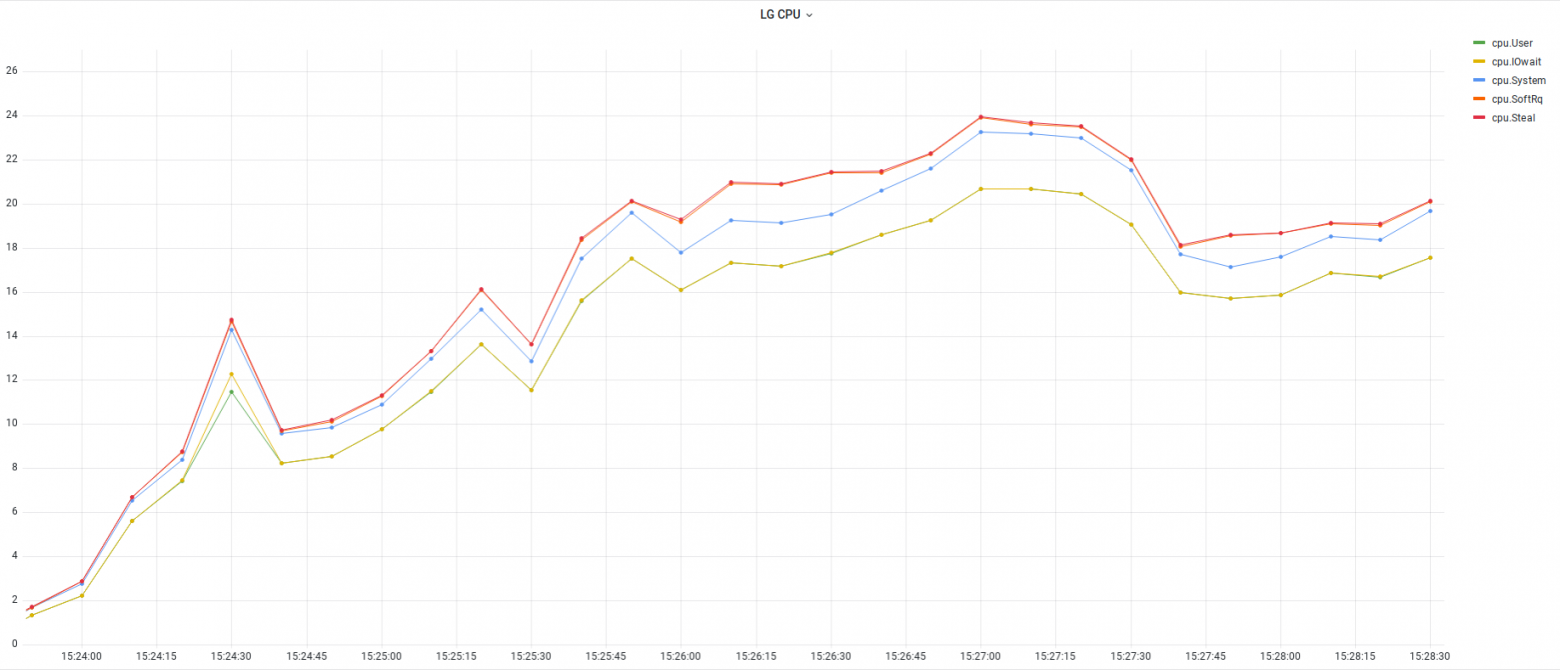

При этом утилизируется только одно ядро виртуальной машины.

Так как использовалось только одно ядро, утилизация CPU была в пределах 25%.

После начала нестабильной работы время отклика начало расти.

Оперативная память утилизировалась несущественно.

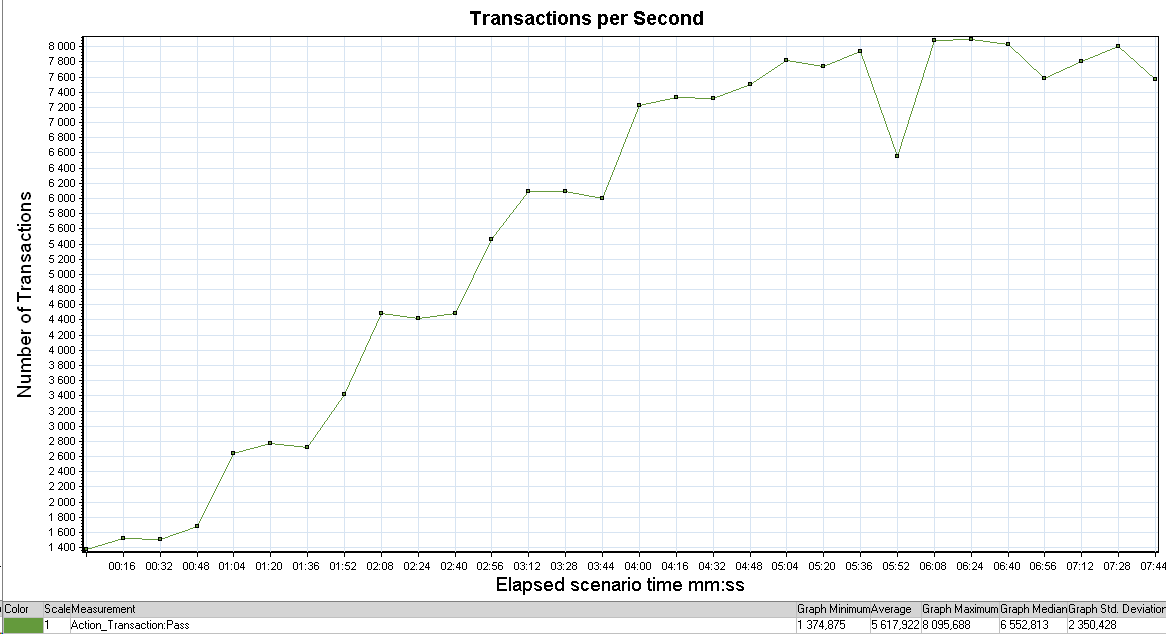

MF LoadRunner Для тестов использовалась верся 2021 build 371, тип скрипта WebHTTP, к сожалению простыми путями указать интервал запуска итераций меньше секунды в LoadRunner не представляется возможным, никакой паузы не указывалось. Запускались 50 пользователей (ограничение бесплатной версии) по одному в минуту.

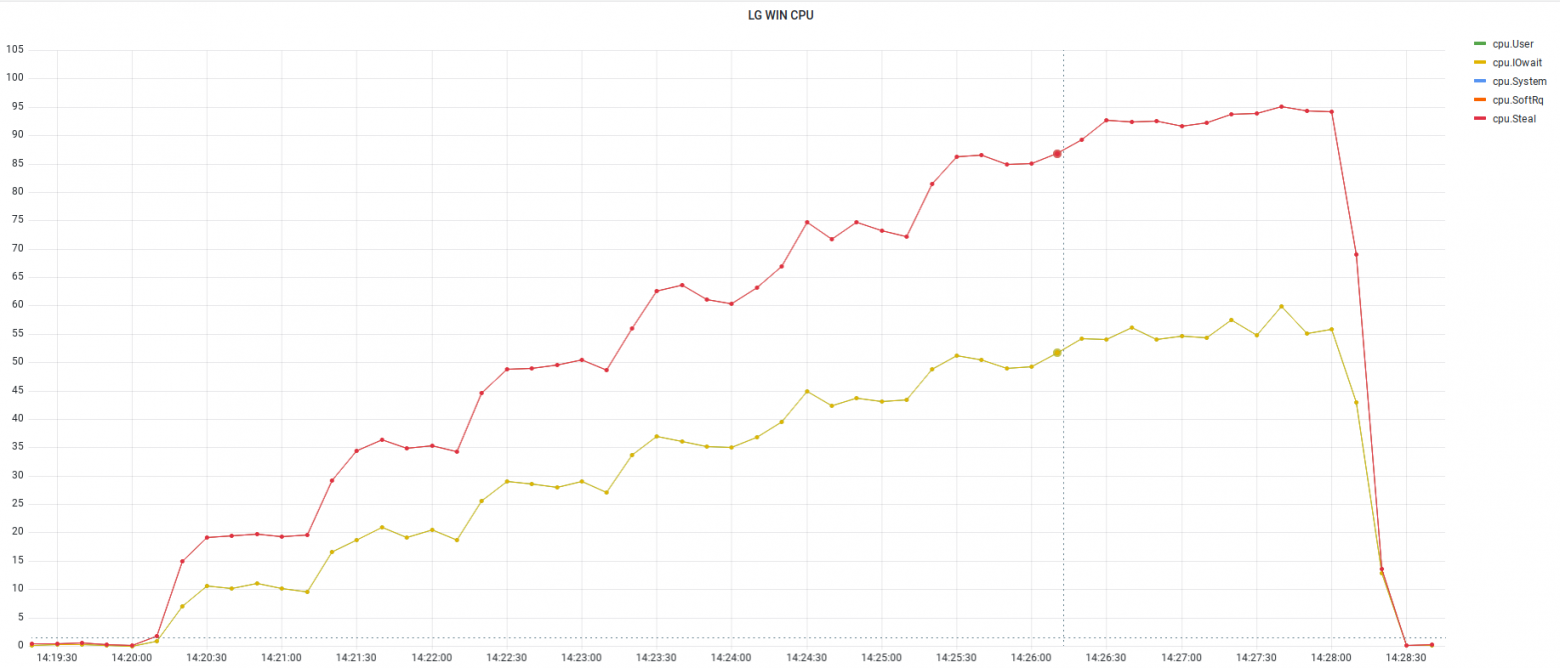

В RunTimeSettings обязательно нужно снять галочку Sumulate a new user on each iteration, иначе на каждый раз создается новое подключение и подключения быстро заканчиваются. Стабильный рост производительности продолжался примерно до 7800 запросов в секунду, пока не закончились ресурсы CPU.

Утилизация CPU росла пропорционально нагрузке.

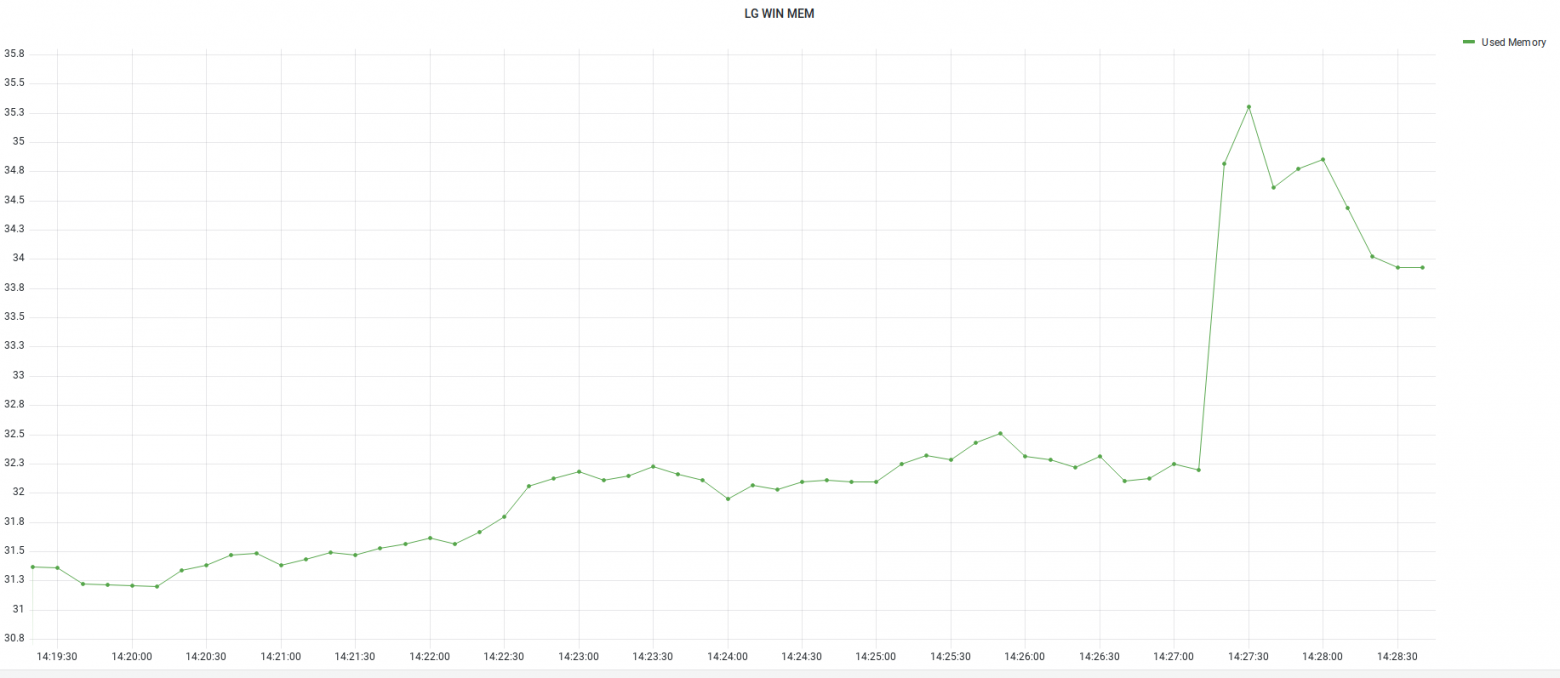

Оперативная память утилизировалась незначительно, небольшой рост наблюдается при достижении максимальной производительности.

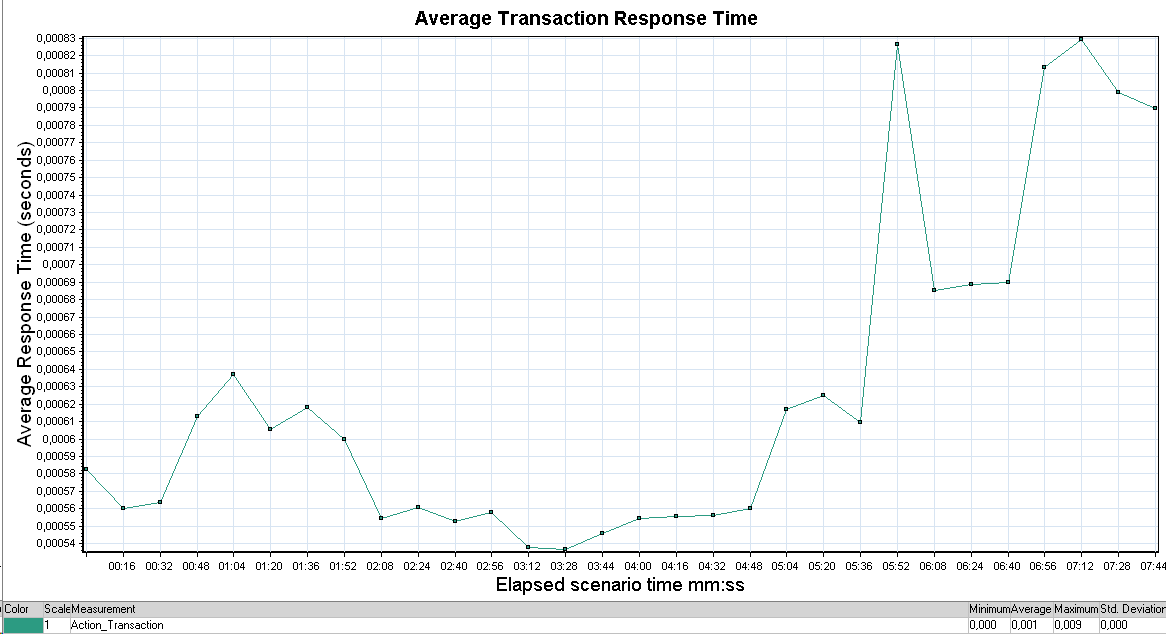

Время отклика начало немного расти после достижения максимальной производительности.

Итоговая таблица

Выскажу свое впечатление по каждому инструменту по результатам тестов.

Как видно, каждый инструмент хорош для своих целей, поэтому не стоит воспринимать этот тест как рейтинг инструментов тестирования производительности. Возможно инструмент показавший себя плохо в данном тесте, будет лидером в других условиях. |