Что пишут в блогах

- Перестать лайкать лайки

- Питер Сенге. Пятая дисциплина. Искусство и практика обучающейся организации

- Итоги 2025 года (родилась дочка, конференции, курс по ChatGPT)

- ChatGPT, подсчитай количество страниц в книге и авторских листов

- Вайб-кодинг и вайб-тестинг — полный гайд на реальных проектах в Cursor и ChatGPT

- Новогодний QA квиз

- Не просри свое время

- Гуру на Урале 4 декабря

- Мои 12 недель в году. Часть 32 (ДР Влада и мой, болезни...)

- Опрос удовлетворенности работой 2025

Что пишут в блогах (EN)

- The people who lift you - Why mentors matter more than we admit

- Bucket of trouble, if you don't keep an eye on AI

- 2025 in review

- Things which were not on my 2025 bingo card

- 2025 - The Year in Review

- 2026 – Changing Gears

- How should we test this? Part 6 - Reporting

- User Error

- Dis Is Weird

- Software Testing Weekly – 294th Issue

Онлайн-тренинги

-

Автоматизация функционального тестированияНачало: 30 января 2026

-

Тестирование REST APIНачало: 2 февраля 2026

-

Тестировщик ПО: интенсивный курс (ПОИНТ) со стажировкойНачало: 3 февраля 2026

-

Школа тест-менеджеров v. 2.0Начало: 4 февраля 2026

-

Python для начинающихНачало: 5 февраля 2026

-

Азбука ITНачало: 5 февраля 2026

-

Автоматизация тестов для REST API при помощи PostmanНачало: 5 февраля 2026

-

Инженер по тестированию программного обеспеченияНачало: 5 февраля 2026

-

Применение ChatGPT в тестированииНачало: 5 февраля 2026

-

Аудит и оптимизация QA-процессовНачало: 6 февраля 2026

-

Тестирование веб-приложений 2.0Начало: 6 февраля 2026

-

Школа Тест-АналитикаНачало: 11 февраля 2026

-

Школа для начинающих тестировщиковНачало: 12 февраля 2026

-

Регулярные выражения в тестированииНачало: 12 февраля 2026

-

SQL: Инструменты тестировщикаНачало: 12 февраля 2026

-

Chrome DevTools: Инструменты тестировщикаНачало: 12 февраля 2026

-

Docker: инструменты тестировщикаНачало: 12 февраля 2026

-

Bash: инструменты тестировщикаНачало: 12 февраля 2026

-

Git: инструменты тестировщикаНачало: 12 февраля 2026

-

Программирование на C# для тестировщиковНачало: 13 февраля 2026

-

Техники локализации плавающих дефектовНачало: 16 февраля 2026

-

Логи как инструмент тестировщикаНачало: 16 февраля 2026

-

Charles Proxy как инструмент тестировщикаНачало: 19 февраля 2026

-

Тестирование GraphQL APIНачало: 19 февраля 2026

-

CSS и Xpath: инструменты тестировщикаНачало: 19 февраля 2026

-

Selenium IDE 3: стартовый уровеньНачало: 20 февраля 2026

-

Программирование на Python для тестировщиковНачало: 20 февраля 2026

-

Автоматизация тестирования REST API на PythonНачало: 25 февраля 2026

-

Тестирование мобильных приложений 2.0Начало: 25 февраля 2026

-

Автоматизация тестирования REST API на JavaНачало: 25 февраля 2026

-

Тестирование безопасностиНачало: 25 февраля 2026

-

Практикум по тест-дизайну 2.0Начало: 27 февраля 2026

-

Тестирование производительности: JMeter 5Начало: 27 февраля 2026

-

Организация автоматизированного тестированияНачало: 6 марта 2026

-

Программирование на Java для тестировщиковНачало: 6 марта 2026

-

Тестирование без требований: выявление и восстановление информации о продуктеНачало: 9 марта 2026

-

Создание и управление командой тестированияНачало: 19 марта 2026

| Метод бисекционного деления в тестировании |

| 21.10.2019 00:00 |

|

Автор: Назина (Киселева) Ольга (автор тренинга Школа для начинающих тестировщиков)

Иногда баги сами нас находят. Вот мы впихали большую строку данных — и система подвисла. Это она из-за 1 млн символов упала? Или ей какой-то конкретный не понравился?

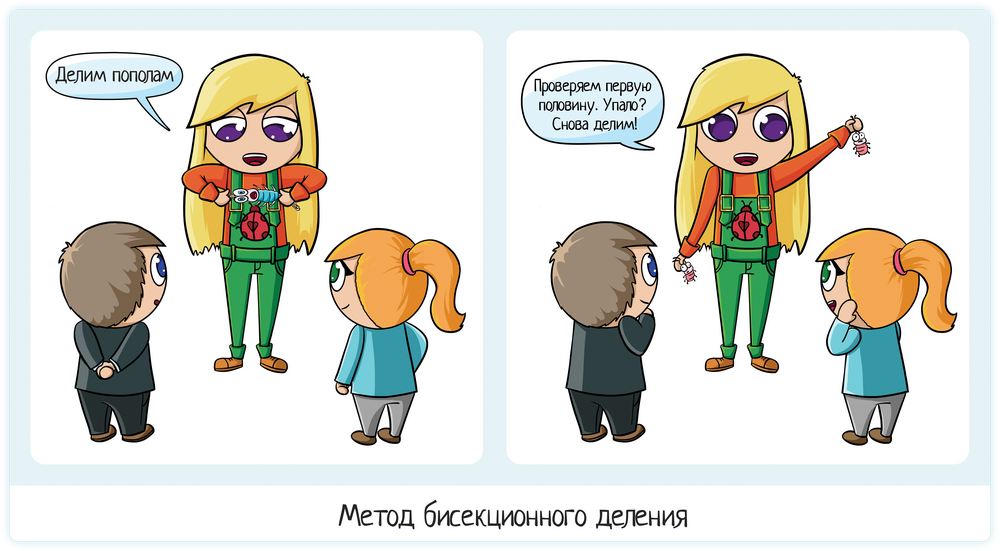

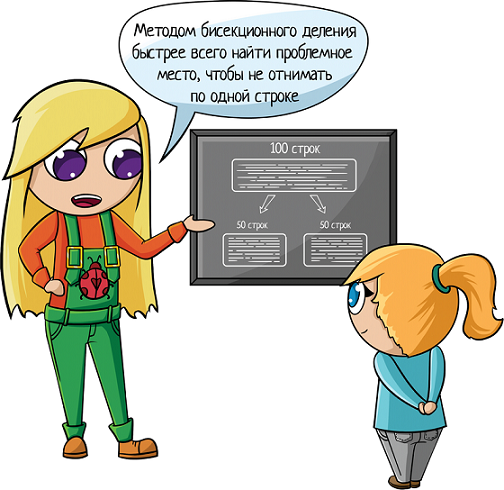

Как найти минимальные данные для воспроизведения бага? Если есть какие-то подсказки в логах, применяем их. Если подсказок нет, то самый оптимальный метод — метод бисекционного деления (также известный как метод «деления пополам» или «дихотомия»). Описание метода Метод применяется для поиска точного места падения:

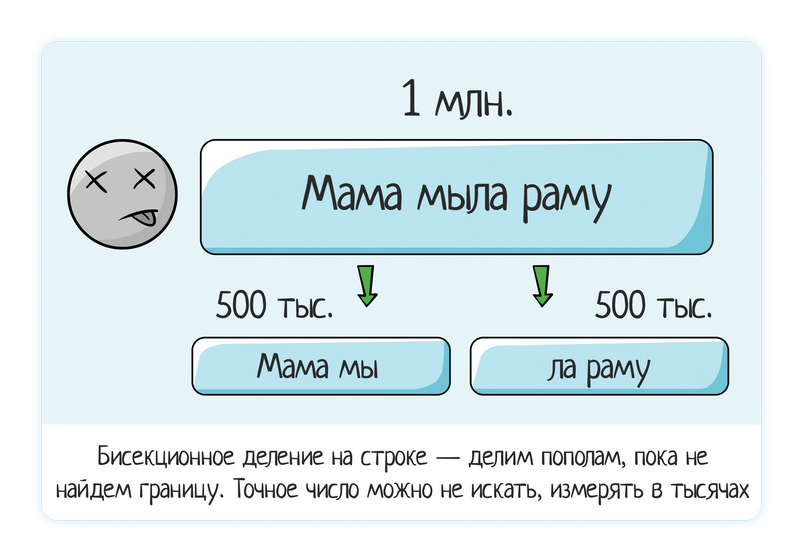

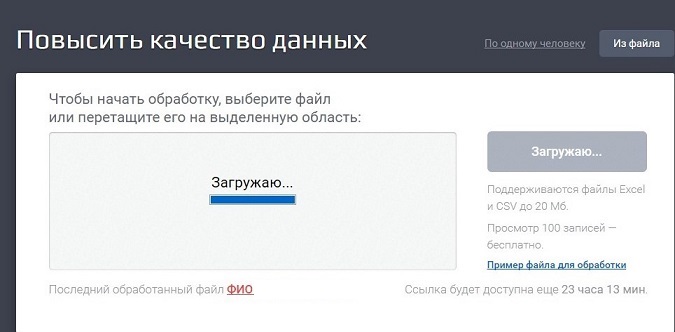

Применение тестировщикамиСтрока данных Загрузили строку в 1 млн данных — система зависла. Файл Загрузили файл — упал! Как, почему? Сначала пытаемся сами проанализировать, что могло повлиять, что проверял наш тест? В этом фишка главного правила «сначала позитив, потом негатив». Если не пытаться запихивать в один тест все и сразу:

Вот тут будет тяжело локализовать. А если разделять проверки:

То уже примерно понятно, в чем причина. Например, падает на большом количестве строк — от 100 тысяч. Ок, ищем более точную границу с помощью бисекционного деления:

Этот баг нашли студенты в Дадате. Туда можно грузить файлы с данными, система эти данные обработает и стандартизирует: исправит опечатки, определит недостающую информацию по справочникам (код КЛАДР, ФИАС, геокоординаты, район города, индекс...). Но помним, что свою теорию тоже надо тестировать. Правда ли, что проблема именно в количестве строк, а не данных внутри файла? Проверить это очень легко — создаете файл на 5000 строк с одним-единственным «позитивным» значением. Тем значением, которое точно работает, которое вы уже проверяли ранее. Если падения нет, значит, тут дело нечисто =)) Похоже, теория о количестве строк была ошибочная и дело в самих данных.

В итоге вместо бага «Падает файл, хз почему, вот в аттаче файл на 2гб» вы ставите продуманный и локализованный баг: «Падает файл, если внутри дата формата ДД/ММ/ГГГГГ». И тогда вам не нужен уже файл на 2гб, вам хватит файла на одну строку и одну колонку! Применение разработчикамиНа большом объеме данных тестировщик не ищет четкую границу, потому что это неразумно делать вручную. А вот разработчики применяют метод бисекционного деления в коде и всегда могут найти конкретное место падения. Ведь делить до победного будет система, а не человек!

Так что мозг надо включать везде — как на ручном тестировании, так и при написании программного кода. Всегда надо понимать, когда остановиться. Только в случае ручного тестирования это будет «примерно найти границу», а в разработке «остановиться, если падений много». РезюмеМетод бисекционного деления применяется для поиска точного места падения и локализации бага.

|